Използвам различни инструменти за уеб скрапиране за a няколко години сега за събиране на данни за моите аналитични отчети.

Наскоро попаднах на ScraperAPI и бях напълно впечатлен от възможностите му.

Сега в този подробен преглед на ScraperAPI ще споделя личния си опит с използването на ScraperAPI, ще обясня всички негови ключови функции, Ръководство стъпка по стъпка да го използвате, а също и да предоставите информация за някои безплатни ресурси предлага се от ScraperAPI.

Защо ви е необходим инструмент за уеб скрапиране?

Ако сте на работа, на която редовно трябва да събирате данни от различни уебсайтове, които да включите в отчетите за анализ, които създавате.

Ръчно извличане данни от уебсайтове може да бъде досадно и отнема много време. Инструментите за уеб скрапинг автоматизират този процес чрез програмно извличане на данни от уеб страници.

Ако търсите мощен инструмент за уеб скрапинг, който може да ви помогне да събирате ефективно всякакви данни от електронна търговия сайтове, сайтове за ревюта, обяви, резултати от търсенето страници и др. Ключовите неща, от които се нуждаехте, бяха:

След като тествах много инструменти, най-накрая открих ScraperAPI, който отговаря на всичките ми изисквания и може да бъде от полза и за вас. Сега нека да разгледаме подробен преглед на ScraperAPI.

Какво е ScraperAPI?

ScraperAPI е API за уеб скрапиране, който ви позволява да извличате данни от почти всеки уебсайт, използвайки REST API извиквания.

Той се справя с всички сложности на уеб скрапинг като пълномощници, браузъри, CAPTCHA и т.н. зад кулисите, за да можете да се съсредоточите само върху получаването на данните, от които се нуждаете.

ScraperAPI е основан през 2018 и бързо се превърна в един от най-популярните и надеждни изстъргване в мрежата услуги.

Основните причини за популярността му са простото и бързо извличане на данни с помощта на API повиквания, мощно асинхронно сканиране за широкомащабно събиране на данни, вградени прокси сървъри и CAPTCHA решаване за безпроблемно сканиране и обширна документация и поддръжка за интеграция.

Според моя опит ScraperAPI решава двете най-големи болни точки на уеб скрапинга – скорост и мащаб. Позволява ми да извличам данни от хиляди уеб страници на час без грешки при изтриване.

Ключови предложения на ScraperAPI

ScraperAPI предлага различни решения и функции за безпроблемно уеб скрапиране. Ето някои от най-полезните му възможности:

1. Async Scraper Service

Услугата Async Scraper на ScraperAPI позволява едновременното изпълнение на широкомащабни задания за уеб скрапинг при 99.99% успех.

Той използва усъвършенствани механизми за заобикаляне на системите против изтриване и връщане на исканите данни чрез просто извикване на API.

Асинхронният скрепер изпраща задания през крайната точка async.scraperapi.com. След това лостове машинно обучение и статистически анализ за определяне на оптималната комбинация от IP адреси, заглавки, решаване на CAPTCHA и други конфигурации за улесняване на изтриването дори на най-трудните уебсайтове.

Потребителите могат да сканират милиони URL адреси, без да управляват изчакванията или да правят повторни опити – асинхронният скрепер обработва всичко автоматично. Резултатите се изпращат обратно чрез статус URL или уеб кукичка веднага щом изтриването приключи.

Основните предимства включват вграден Изобразяване на JavaScript, географско насочване, автоматична IP ротация, анализ на структурирани данни и решаване на CAPTCHA.

Асинхронният скрепер носи цялата мощ на традиционния API на ScraperAPI с добавената възможност за изтриване на неограничен брой страници едновременно.

Асинхронният скрепер е идеален за мащабни проекти за скрапиране, които изискват данни от милиони URL адреси. Неговите автоматизирани механизми и надеждност го правят идеален за тези, които трябва да изстъргват трудни уебсайтове в мащаб.

2. Изобразяване на JavaScript

Много уебсайтове днес разчитат в голяма степен на JavaScript за изобразяване съдържание. Нормалните скрепери не могат да извличат данни от съдържание, генерирано от JavaScript.

Впечатляващо е, че безглавните браузъри на ScraperAPI изобразяват JavaScript в движение, преди да изтрият. Това позволява безпроблемно събиране на данни дори от най-сложните JavaScript сайтове.

3. Разрешаване на CAPTCHA

CAPTCHA могат да блокират скреперите от достъп до данни. ScraperAPI има вграден OCR възможности за автоматично разрешаване на CAPTCHA в реално време. Това заобикаля CAPTCHA без усилие, без ръчна работа.

4. Структурирани данни

ScraperAPI може да извлича структурирани данни като информация за продукта, данни за рецензии, резултати от търсене и т.н., и да извежда JSON формат.

Тези структурирани данни са лесно използваеми за приложения за анализ и машинно обучение, без да е необходимо почистване на данните.

Например, използвах ScraperAPI, за да извлека 5000 Amazon списъци с продукти с пълна структурирана информация като заглавие, рейтинг, цена и т.н. в едно извикване на API.

5. Google и Amazon Scraping

ScraperAPI предоставя специализирани решения за извличане на данни от Google и Amazon. Той позволява на потребителите да извличат структурирани данни от Google Shopping, Google Search, API за рекламиране на продукти на Amazon и др.

Това беше безценно за мен да получа списъци с продукти, резултати от търсене, рецензии, данни за цените и т.н. от Amazon и Google.

За Google той може да събира данни от многобройни заявки за търсене и да ги конвертира в структурирани JSON данни, които могат да се използват за различни цели, като проучване на пазара, SEO инструментии наблюдение на конкуренти.

За Amazon, ScraperAPI улеснява мащабното сканиране на данни, заобикаляйки технологията за антискрапиране на Amazon. Той предоставя ръководство за изчерпване на данни на Amazon с помощта на Python Scrapy и ScraperAPI и разполага с функция за автоматично анализиране, която позволява събирането на JSON данни от Amazon с помощта на стандартна крайна точка на API, връщайки цялата подходяща информация в структуриран формат.

6. Тръбопровод за данни

Функцията Data Pipeline на ScraperAPI ви позволява да автоматизирате мащабни проекти за изчерпване на данни, без да пишете нито един ред код.

Това нисък код решението намалява необходимостта от сложно кодиране и поддръжка на вашия собствен скрепер, като по този начин намалява инженерните ресурси и разходите.

С Data Pipeline можете да планирате автоматично събиране на данни за до 10,000 XNUMX URL адреса, което го прави идеален за управление на големи проекти за извличане на данни.

Той ви осигурява пълен контрол върху това как и къде да получите вашите данни, като ви позволява да изпращате данни директно до всяка папка във вашето приложение, място за съхранение на документи или електронна поща.

В допълнение към тях, функцията Data Pipeline също предлага интеграции на webhook, елиминирайки необходимостта от ръчно изтегляне или копиране-поставяне.

Изключителен купон за ScraperAPI 2024 г

10% ОТСТЪПКА от купон за ScraperAPI

изключителен

Използвайте нашия изключителен код на купон “affnico10” и вземете фиксирани 10% отстъпка за всеки абонаментен план на ScraperAPI.

Запиши 10%

Трябва да се отбележи, че можете да спестите 20%, ако приложите нашия код на купон “affnico10” с годишно таксуване, т.е. 10% с нашия код за отстъпка + 10% с годишното таксуване на ScraperAPI.

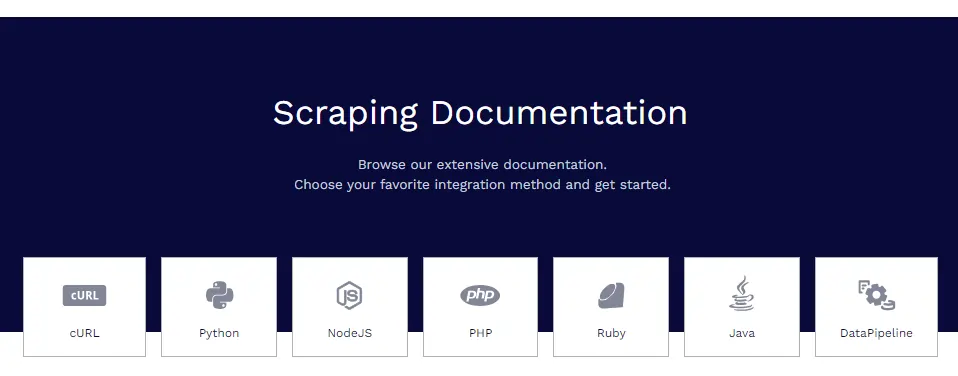

Документация на ScraperAPI

ScraperAPI разполага с обширна и добре организирана документация, която обхваща всички негови функции в дълбочина с примери за код в Python, Node.js, Ruby, PHP и др.

Някои от полезните ресурси за документация са:

- Първи стъпки – Инсталиране, удостоверяване и първо извикване на API.

- Извличане на структурирани данни – Извличане на структурирани данни от електронна търговия, обяви, директории и др.

- Услуги на Google – Ръководства за копиране на Google Shopping, Google Maps, Google Flights и др.

- Тръбопроводи за данни – Настройване на автоматизирани конвейери за извличане.

- Формат на отговора – Подробности за изходната структура на JSON.

Документите съдържат всичко, от което се нуждаете, за да станете опитни в сканирането на данни със ScraperAPI.

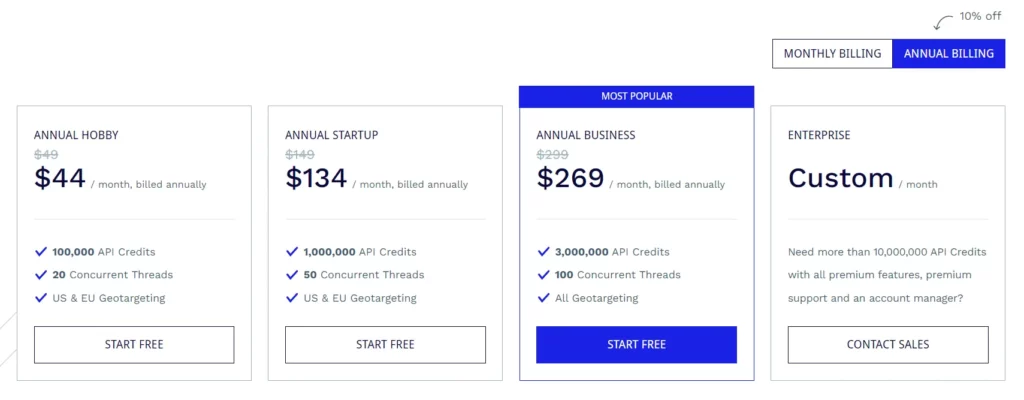

Абонаментни планове за ScraperAPI

План за хоби ($49/месец)

- 100,000 XNUMX API кредита

- 20 едновременни нишки

- Геотаргетиране в САЩ и ЕС

Стартов план ($149/месец)

- 1,000,000 XNUMX API кредита

- 50 едновременни нишки

- Геотаргетиране в САЩ и ЕС

Бизнес план ($299/месец)

- 3,000,000 XNUMX API кредита

- 100 едновременни нишки

- Всички опции за географско насочване

Корпоративен план (персонализирано ценообразуване)

- Персонализиран план за повече от 10,000,000 XNUMX XNUMX API кредита.

- Премиум функции, премиум поддръжка и специален мениджър на акаунти.

Всички планове се предлагат с функции като изобразяване на JavaScript, премиум проксита, автоматично анализиране на JSON, интелигентно завъртане на прокси, поддръжка на персонализирани заглавки, неограничена честотна лента, автоматични повторни опити, настолни и мобилни потребителски агенти, 99.9% гаранция за непрекъсната работа, поддръжка на персонализирани сесии, CAPTCHA и анти-бот откриване и професионална поддръжка.

ScraperAPI също така предоставя безплатна пробна версия, която включва 5,000 API кредита за 7 дни.

Някои безплатни ресурси от ScraperAPI

В допълнение към API, ScraperAPI предлага и много безплатни ресурси за изучаване на уеб скрапинг:

Учебен център за уеб скрапинг

- Учебният център за уеб скрапинг съдържа безплатни уроци и ръководства за овладяване на уеб скрапинг с Python и други езици.

Електронните книги

ScraperAPI публикува полезни безплатни електронни книги като „Web Scraping: The Basics Explained“, които учат основите на уеб скрапинга.

Webinars

Те хостват безплатни уеб семинари на теми като „Изтриване на JavaScript уебсайтове“, „Изграждане на тръбопроводи за данни“ и т.н., които предоставят полезни съвети.

Демо проекти

Демонстрационните проекти включват напълно кодирани уеб скриптове за скрапинг за реални задачи за скрапинг, от които можете да се поучите.

Блог

ScraperAPI блог съдържа уроци и статии за най-добрите практики за уеб скрапинг. Тези безплатни ресурси са безценни за овладяване на уеб скрапинг без разходи. Те допълват API добре.

Често задавани въпроси

ScraperAPI обработва ли проксита и браузъри?

Да, ScraperAPI управлява разпределена мрежа от проксита и браузъри автоматично във фонов режим. Изобщо не е нужно да се притеснявате за прокситата.

Мога ли да изтривам данни зад влизания?

Да, ScraperAPI поддържа изчерпване на данни зад влизания чрез предаване на бисквитки в заявката за API за поддържане на сесии.

ScraperAPI интегрира ли се с Python?

Да, ScraperAPI предоставя библиотека на Python, която прави интеграцията безпроблемна. Предлагат се и библиотеки за Node.js, Ruby, PHP и др.

Мога ли да изтривам JavaScript уебсайтове?

Определено безглавните браузъри на ScraperAPI изобразяват JavaScript преди изтриване, така че JS сайтовете не са проблем.

Завършване на прегледа на ScraperAPI

След широко използване на ScraperAPI в моите различни проекти, мога уверено да гарантирам за неговото качество и надеждност.

За моите нужди от уеб скрапинг ScraperAPI отбелязва всички правилни квадратчета. Опитах конкуренти като Apify, Octoparse, ParseHub и др., но намирам ScraperAPI за най-добрия по отношение на функции, удобство и ценообразуване.

Силно препоръчвам ScraperAPI на всеки индивид, екип или компания, които трябва да извличат уеб данни в мащаб. Това със сигурност ще ви спести часове сложно кодиране и настройка, така че да можете да се съсредоточите върху извличането на прозрения от данните.

Бързи връзки:

- Преглед на HilltopAds 2023: Мрежата с висока CPM на всички GEO е тук

- Преглед на Zeydoo 2023: Увеличете максимално печалбите си със Zeydoo

- 8 най-добри браузъра Antidetect за филиали 2023 (безплатни и платени)

- Преглед на Minea 2023: Разширен инструмент за проучване на продукти (купони и промоционални кодове на Minea)

филиал разкриване: Тази публикация може да съдържа някои партньорски връзки, което означава, че може да получим комисионна, ако закупите нещо, което ние препоръчваме, без допълнително заплащане за вас (никакви!)

![Writesonic Review 2024: Най-добрият инструмент за писане на текстове [Плюсове и минуси] 11 Writesonic Review 2024: Най-добрият инструмент за писане на текстове [Плюсове и минуси]](https://bloggingeclipse.com/wp-content/uploads/2022/03/Writesonic-Review-1024x512.webp)