Ich verwende seit einiger Zeit verschiedene Web-Scraping-Tools ein paar Jahre Jetzt möchte ich Daten für meine Analyseberichte sammeln.

Kürzlich bin ich auf ScraperAPI gestoßen und war von seinen Fähigkeiten durchweg beeindruckt.

In diesem ausführlichen ScraperAPI-Test werde ich nun meine persönlichen Erfahrungen mit ScraperAPI teilen und alle wichtigen Funktionen erläutern Schritt-für-Schritt-Anleitung um es zu verwenden, und stellen Sie auch Informationen zu einigen bereit freie Ressourcen angeboten von ScraperAPI.

Warum brauchen Sie ein Web-Scraping-Tool?

Wenn Sie einen Job haben, bei dem Sie regelmäßig Daten von verschiedenen Websites sammeln müssen, um sie in die von Ihnen erstellten Analyseberichte einzubeziehen.

Manuelles Extrahieren technische Daten von Websites kann mühsam und zeitaufwändig sein. Web-Scraping-Tools automatisieren diesen Prozess, indem sie programmgesteuert Daten aus Webseiten extrahieren.

Wenn Sie nach einem leistungsstarken Web-Scraping-Tool suchen, mit dem Sie alle Arten von Daten effizient sammeln können e-commerce Websites, Bewertungsseiten, Kleinanzeigen, Suchmaschinen-Ergebnisse Seiten und mehr. Die wichtigsten Dinge, die Sie brauchten, waren:

Nachdem ich viele Tools getestet hatte, habe ich schließlich ScraperAPI gefunden, das alle meine Anforderungen erfüllt und auch Ihnen Vorteile bieten kann. Schauen wir uns nun einen detaillierten Testbericht von ScraperAPI an.

Was ist ScraperAPI?

SchaberAPI ist eine Web-Scraping-API, mit der Sie mithilfe von REST-API-Aufrufen Daten von nahezu jeder Website extrahieren können.

Es bewältigt alle Komplexitäten des Web-Scrapings Proxies, Browser, CAPTCHAs usw. hinter den Kulissen, sodass Sie sich darauf konzentrieren können, nur die Daten zu erhalten, die Sie benötigen.

ScraperAPI wurde in gegründet 2018 und hat sich schnell zu einem der beliebtesten und zuverlässigsten entwickelt Bahnkratzen Dienstleistungen.

Die Hauptgründe für seine Beliebtheit sind die einfache und schnelle Datenextraktion mithilfe von API-Aufrufen, leistungsstarkes asynchrones Scraping für die Erfassung umfangreicher Daten, integrierte Proxys und CAPTCHA-Lösung für nahtloses Scraping sowie umfangreiche Dokumentation und Integrationsunterstützung.

Meiner Erfahrung nach löst ScraperAPI die beiden größten Probleme beim Web-Scraping – Geschwindigkeit und Skalierbarkeit. Es hat mir ermöglicht, Daten von Tausenden von Webseiten pro Stunde zu extrahieren, ohne dass es zu Scraping-Fehlern kam.

Die wichtigsten Angebote von ScraperAPI

ScraperAPI bietet verschiedene Lösungen und Funktionen für müheloses Web Scraping. Hier sind einige seiner nützlichsten Funktionen:

1. Async Scraper-Dienst

Der Async Scraper Service von ScraperAPI ermöglicht die gleichzeitige Ausführung umfangreicher Web-Scraping-Jobs mit einer Erfolgsquote von 99.99 %.

Es nutzt fortschrittliche Mechanismen, um Anti-Scraping-Systeme zu umgehen und angeforderte Daten über einen einfachen API-Aufruf zurückzugeben.

Der asynchrone Scraper sendet Jobs über den Endpunkt async.scraperapi.com. Es nutzt dann Maschinelles Lernen und statistische Analyse, um die optimale Kombination von IPs, Headern, CAPTCHA-Lösungen und anderen Konfigurationen zu bestimmen, um das Scrapen selbst der schwierigsten Websites zu erleichtern.

Benutzer können Millionen von URLs scrapen, ohne selbst Timeouts oder Wiederholungsversuche verwalten zu müssen – der asynchrone Scraper erledigt alles automatisch. Ergebnisse werden über einen Status zurückgesendet URL oder Webhook, sobald das Scraping abgeschlossen ist.

Zu den Hauptvorteilen gehört die integrierte JavaScript-Rendering, Geotargeting, automatische IP-Rotation, strukturierte Datenanalyse und CAPTCHA-Lösung.

Der asynchrone Scraper bietet die gesamte Leistung der traditionellen API von ScraperAPI mit der zusätzlichen Möglichkeit, unbegrenzt viele Seiten gleichzeitig zu scrapen.

Der asynchrone Scraper ist ideal für groß angelegte Scraping-Projekte, die Daten von Millionen von URLs benötigen. Seine automatisierten Mechanismen und seine Zuverlässigkeit machen es perfekt für diejenigen, die schwierige Websites in großem Maßstab durchsuchen müssen.

2. JavaScript-Rendering

Heutzutage verlassen sich viele Websites zum Rendern stark auf JavaScript Inhalt. Normale Scraper können keine Daten aus JavaScript-generierten Inhalten extrahieren.

Beeindruckend ist, dass die Headless-Browser von ScraperAPI vor dem Scraping JavaScript im Handumdrehen rendern. Dies ermöglicht die nahtlose Erfassung von Daten selbst von den komplexesten JavaScript-Sites.

3. CAPTCHA-Lösung

CAPTCHAs können Scraper daran hindern, auf Daten zuzugreifen. ScraperAPI ist integriert OCR Funktionen zur automatischen Lösung von CAPTCHAs in Echtzeit. Dadurch werden CAPTCHAs mühelos und ohne manuelle Arbeit umgangen.

4. Strukturierte Daten

ScraperAPI kann strukturierte Daten wie Produktinformationen, Bewertungsdaten, Suchergebnisse usw. extrahieren und in ausgeben JSON Format.

Diese strukturierten Daten können problemlos für Analysen und maschinelle Lernanwendungen verwendet werden, ohne dass eine Datenbereinigung erforderlich ist.

Ich habe zum Beispiel ScraperAPI verwendet, um 5000 Amazon zu extrahieren Produktlisten mit vollständig strukturierten Informationen wie Titel, Bewertung, Preis usw. in einem einzigen API-Aufruf.

5. Google- und Amazon-Scraping

ScraperAPI bietet spezielle Lösungen zum Scrapen von Daten von Google und Amazon. Es ermöglicht Benutzern, strukturierte Daten aus Google Shopping, der Google-Suche, der Amazon Product Advertising API und mehr zu extrahieren.

Für mich war es von unschätzbarem Wert, Produktlisten, Suchergebnisse, Rezensionen, Preisdaten usw. von Amazon und Google zu erhalten.

Für Google kann es Daten aus zahlreichen Suchanfragen sammeln und in strukturierte JSON-Daten umwandeln, die für verschiedene Zwecke wie Marktforschung, SEO-Toolsund Wettbewerbsüberwachung.

Für Amazon erleichtert ScraperAPI das Daten-Scraping in großem Maßstab und umgeht die Anti-Scraping-Technologie von Amazon. Es bietet eine Anleitung zum Scrapen von Amazon-Daten mit Python Scrapy und ScraperAPI und verfügt über eine Auto-Parsing-Funktion, die die Erfassung von JSON-Daten von Amazon mithilfe eines Standard-API-Endpunkts ermöglicht und alle relevanten Informationen in einem strukturierten Format zurückgibt.

6. Datenpipeline

Mit der Data Pipeline-Funktion von ScraperAPI können Sie umfangreiche Daten-Scraping-Projekte automatisieren, ohne eine einzige Codezeile schreiben zu müssen.

Dieser Low-Code Die Lösung reduziert den Bedarf an komplexer Codierung und Wartung Ihres eigenen Schabers und reduziert so den technischen Aufwand und die Kosten.

Mit Data Pipeline können Sie die automatische Datenerfassung für bis zu 10,000 URLs planen, was es ideal für die Verwaltung großer Datenextraktionsprojekte macht.

Es gibt Ihnen die vollständige Kontrolle darüber, wie und wo Sie Ihre Daten erhalten, und ermöglicht Ihnen, Daten direkt an jeden Ordner in Ihrer Anwendung, an den Dokumentenspeicherplatz usw. zu senden E-Mail.

Darüber hinaus bietet die Data Pipeline-Funktion auch Webhook-Integrationen, sodass manuelle Downloads oder das Einfügen von Kopien nicht mehr erforderlich sind.

Exklusiver ScraperAPI-Gutschein 2024

10 % Rabatt auf den ScraperAPI-Gutschein

exklusiv

Nutzen Sie unseren exklusiven Gutscheincode „affnico10” und erhalten Sie pauschal 10 % Rabatt auf jedes ScraperAPI-Abonnement.

10% sparen

Bemerkenswert ist, dass Sie 20 % sparen können, wenn Sie unseren Gutscheincode „affnico10” mit jährlicher Abrechnung, d. h.; 10 % mit unserem Rabattcode + 10 % mit der jährlichen Abrechnung von ScraperAPI.

ScraperAPI-Dokumentation

ScraperAPI verfügt über eine umfangreiche und gut organisierte Dokumentation, die alle Funktionen ausführlich mit Codebeispielen in Python, Node.js, Ruby, PHP und mehr abdeckt.

Einige der hilfreichen Dokumentationsressourcen sind:

- Erste Schritte – Installation, Authentifizierung und erster API-Aufruf.

- Extrahieren strukturierter Daten – Auslesen strukturierter Daten aus E-Commerce, Kleinanzeigen, Verzeichnissen usw.

- Google Services – Anleitungen zum Scrapen von Google Shopping, Google Maps, Google Flights und mehr.

- Datenpipelines – Einrichten automatisierter Scraping-Pipelines.

- Antwortformat – Details zur JSON-Ausgabestruktur.

Die Dokumente enthalten alles, was Sie benötigen, um das Scraping von Daten mit ScraperAPI zu beherrschen.

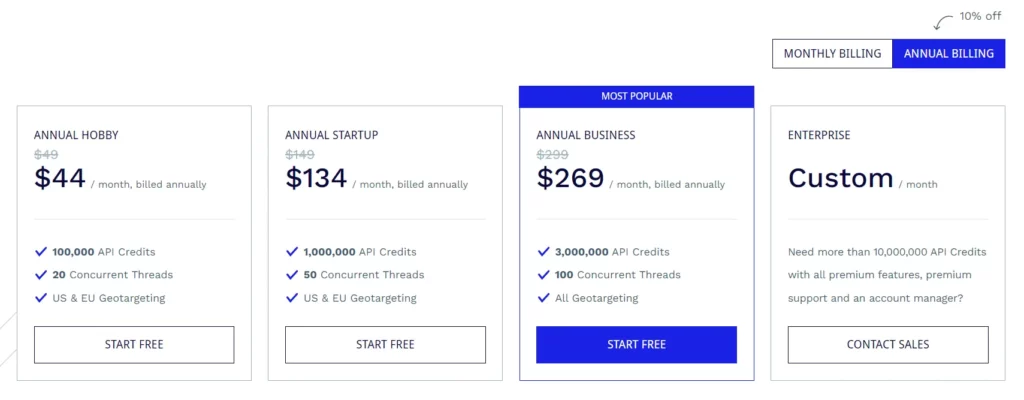

ScraperAPI-Abonnementpläne

Hobbyplan (49 $/Monat)

- 100,000 API-Credits

- 20 gleichzeitige Threads

- Geotargeting in den USA und der EU

Startup-Plan (149 $/Monat)

- 1,000,000 API-Credits

- 50 gleichzeitige Threads

- Geotargeting in den USA und der EU

Geschäftsplan ($299/Monat)

- 3,000,000 API-Credits

- 100 gleichzeitige Threads

- Alle Geotargeting-Optionen

Enterprise-Plan (individuelle Preise)

- Maßgeschneiderter Plan für mehr als 10,000,000 API-Credits.

- Premium-Funktionen, Premium-Support und ein engagierter Account Manager.

Alle Pläne umfassen Funktionen wie JavaScript-Rendering, Premium-Proxys, automatische JSON-Analyse, intelligente Proxy-Rotation, benutzerdefinierte Header-Unterstützung, unbegrenzte Bandbreite, automatische Wiederholungsversuche, Desktop- und mobile Benutzeragenten, 99.9 % Verfügbarkeitsgarantie, benutzerdefinierte Sitzungsunterstützung, CAPTCHA und Anti-Bot Erkennung und professionelle Unterstützung.

ScraperAPI bietet außerdem eine kostenlose Testversion an, die 5,000 API-Credits für 7 Tage umfasst.

Einige kostenlose Ressourcen von ScraperAPI

Zusätzlich zur API bietet ScraperAPI auch viele kostenlose Ressourcen zum Erlernen von Web Scraping:

Web Scraping-Lernzentrum

Das Der Web Scraping Learning Hub enthält kostenlose Tutorials und Anleitungen zum Beherrschen von Web Scraping mit Python und anderen Sprachen.

Ebooks

ScraperAPI hat hilfreiche kostenlose E-Books wie „Web Scraping: The Basics Explained“ veröffentlicht, die die Grundlagen des Web Scraping vermitteln.

Webinare

Sie veranstalten kostenlose Webinare zu Themen wie „Scraping von JavaScript-Websites“, „Aufbau von Datenpipelines“ usw., die umsetzbare Tipps geben.

Demo-Projekte

Die Demoprojekte umfassen vollständig codierte Web-Scraping-Skripte für reale Scraping-Aufgaben, aus denen Sie lernen können.

Blog

ScraperAPIs Blog enthält Tutorials und Artikel zu Best Practices für Web Scraping. Diese kostenlosen Ressourcen sind von unschätzbarem Wert, um Web Scraping kostenlos zu meistern. Sie ergänzen die API schön.

Häufig gestellte Fragen

Verarbeitet ScraperAPI Proxys und Browser?

Ja, ScraperAPI verwaltet ein verteiltes Netzwerk von Proxys und Browsern automatisch im Hintergrund. Sie müssen sich überhaupt keine Sorgen um Proxys machen.

Kann ich Daten hinter Logins extrahieren?

Ja, ScraperAPI unterstützt das Scrapen von Daten hinter Anmeldungen, indem Cookies in der API-Anfrage übergeben werden, um Sitzungen aufrechtzuerhalten.

Lässt sich ScraperAPI in Python integrieren?

Ja, ScraperAPI bietet eine Python-Bibliothek, die eine nahtlose Integration ermöglicht. Bibliotheken für Node.js, Ruby, PHP usw. sind ebenfalls verfügbar.

Kann ich JavaScript-Websites scrapen?

Auf jeden Fall rendern die Headless-Browser von ScraperAPI JavaScript vor dem Scraping, sodass JS-Sites kein Problem darstellen.

Abschluss der ScraperAPI-Rezension

Nachdem ich ScraperAPI in meinen verschiedenen Projekten ausgiebig genutzt habe, kann ich mit Zuversicht für die Qualität und Zuverlässigkeit bürgen.

Für meine Web-Scraping-Anforderungen erfüllt ScraperAPI genau das Richtige. Ich habe Konkurrenten wie Apify, Octoparse, ParseHub usw. ausprobiert, finde aber, dass ScraperAPI in Bezug auf Funktionen, Komfort und Preis das Beste ist.

Ich kann ScraperAPI jeder Einzelperson, jedem Team oder jedem Unternehmen wärmstens empfehlen, das Webdaten in großem Maßstab extrahieren muss. Dadurch ersparen Sie sich mit Sicherheit viele Stunden komplexer Codierungs- und Einrichtungsarbeit, sodass Sie sich darauf konzentrieren können, aus den Daten Erkenntnisse zu gewinnen.

Quick-Links:

- HilltopAds Review 2023: Das All GEOs High CPM-Netzwerk ist da

- Zeydoo Review 2023: Maximieren Sie Ihre Einnahmen mit Zeydoo

- Die 8 besten Antidetect-Browser für Affiliates 2023 (kostenlos und kostenpflichtig)

- Minea Review 2023: Ein fortschrittliches Produktforschungstool (Minea-Gutscheine und Promo-Codes)

Affiliate Offenlegung: Dieser Beitrag kann einige Affiliate-Links enthalten, was bedeutet, dass wir möglicherweise eine Provision erhalten, wenn Sie etwas kaufen, das wir empfehlen, ohne zusätzliche Kosten für Sie (überhaupt keine!).

![Writesonic Review 2024: Das ultimative Copywriting-Tool [Vor- und Nachteile] 16 Writesonic Review 2024: Das ultimative Copywriting-Tool [Vor- und Nachteile]](https://bloggingeclipse.com/wp-content/uploads/2022/03/Writesonic-Review-1024x512.webp)