He estado usando varias herramientas de web scraping durante un pocos años Ahora para recopilar datos para mis informes analíticos.

Recientemente, me encontré con ScraperAPI y quedé completamente impresionado por sus capacidades.

Ahora, en esta revisión detallada de ScraperAPI, compartiré mi experiencia personal con ScraperAPI, explicaré todas sus características clave, Guia paso a paso para usarlo, y también proporcionar información sobre algunos recursos gratuitos ofrecido por ScraperAPI.

¿Por qué necesita una herramienta de raspado web?

Si tiene un trabajo en el que necesita recopilar datos de diferentes sitios web con regularidad para incluirlos en los informes analíticos que crea.

Extrayendo manualmente datos desde sitios web puede ser tedioso y llevar mucho tiempo. Las herramientas de web scraping automatizan este proceso extrayendo datos de páginas web mediante programación.

Si estaba buscando una poderosa herramienta de web scraping que pudiera ayudarlo a recopilar eficientemente todo tipo de datos de comercio electrónico sitios, sitios de reseñas, clasificados, resultados del motor de búsqueda páginas y más. Las cosas clave que necesitabas eran:

Después de probar muchas herramientas, finalmente encontré ScraperAPI que cumplía con todos mis requisitos y también puede beneficiarlo a usted. Ahora echemos un vistazo a una revisión detallada de ScraperAPI.

¿Qué es ScraperAPI?

RaspadorAPI es una API de raspado web que le permite extraer datos de casi cualquier sitio web mediante llamadas API REST.

Maneja todas las complejidades del web scraping como proxies, navegadores, CAPTCHA, etc. detrás de escena para que pueda concentrarse en obtener los datos que necesita.

ScraperAPI fue fundada en 2018 y rápidamente se ha convertido en uno de los más populares y confiables. web scraping servicios.

Las razones clave de su popularidad son la extracción de datos simple y rápida mediante llamadas API, el potente scraping asíncrono para la recopilación de datos a gran escala, los proxies integrados y la resolución CAPTCHA para un scraping sin problemas, y una amplia documentación y soporte de integración.

En mi experiencia, ScraperAPI resuelve los dos mayores problemas del web scraping: velocidad y escala. Me ha permitido extraer datos de miles de páginas web por hora sin fallos de raspado.

Ofertas clave de ScraperAPI

ScraperAPI ofrece varias soluciones y funciones para Web Scraping sin esfuerzo. Estas son algunas de sus capacidades más útiles:

1. Servicio de raspador asíncrono

El servicio Async Scraper de ScraperAPI permite realizar trabajos de web scraping a gran escala de forma simultánea con una tasa de éxito del 99.99 %.

Utiliza mecanismos avanzados para evitar los sistemas anti-scraping y devolver los datos solicitados mediante una simple llamada API.

El raspador asíncrono envía trabajos a través del punto final async.scraperapi.com. Luego aprovecha máquina de aprendizaje y análisis estadístico para determinar la combinación óptima de IP, encabezados, resolución de CAPTCHA y otras configuraciones para facilitar la extracción incluso de los sitios web más difíciles.

Los usuarios pueden extraer millones de URL sin administrar tiempos de espera ni reintentos ellos mismos: el raspador asíncrono lo maneja todo automáticamente. Los resultados se envían a través de un estado. Enlance o webhook tan pronto como se complete el raspado.

Los beneficios clave incluyen incorporado Representación de JavaScript, orientación geográfica, rotación automática de IP, análisis de datos estructurados y resolución de CAPTCHA.

El raspador asíncrono ofrece todo el poder de la API tradicional de ScraperAPI con la capacidad adicional de raspar páginas ilimitadas al mismo tiempo.

El raspador asíncrono es ideal para proyectos de raspado a gran escala que requieren datos de millones de URL. Sus mecanismos automatizados y su confiabilidad lo hacen perfecto para aquellos que necesitan eliminar sitios web difíciles a escala.

2. Representación de JavaScript

Hoy en día, muchos sitios web dependen en gran medida de JavaScript para renderizar contenido. Los raspadores normales no pueden extraer datos del contenido generado por JavaScript.

Sorprendentemente, los navegadores sin cabeza de ScraperAPI procesan JavaScript sobre la marcha antes de realizar el scraping. Esto permite recopilar datos sin problemas incluso desde los sitios JavaScript más complejos.

3. Resolución de CAPTCHA

Los CAPTCHA pueden impedir que los raspadores accedan a los datos. ScraperAPI tiene incorporado OCR capacidades para resolver CAPTCHA automáticamente en tiempo real. Esto evita los CAPTCHA sin esfuerzo y sin ningún trabajo manual.

4. Datos estructurados

ScraperAPI puede extraer datos estructurados como información del producto, datos de revisión, resultados de búsqueda, etc., y generarlos en JSON formato.

Estos datos estructurados se pueden utilizar fácilmente para aplicaciones de análisis y aprendizaje automático sin necesidad de limpieza de datos.

Por ejemplo, utilicé ScraperAPI para extraer 5000 Amazon listados de productos con información estructurada completa como título, calificación, precio, etc. en una sola llamada API.

5. Raspado de Google y Amazon

ScraperAPI proporciona soluciones especializadas para extraer datos de Google y Amazon. Permite a los usuarios extraer datos estructurados de Google Shopping, la Búsqueda de Google, la API de publicidad de productos de Amazon y más.

Esto ha sido invaluable para mí para obtener listados de productos, resultados de búsqueda, reseñas, datos de precios, etc. de Amazon y Google.

Para Google, puede recopilar datos de numerosas consultas de búsqueda y convertirlos en datos JSON estructurados, que pueden usarse para diversos fines, como investigación de mercado, Herramientas de SEOy seguimiento de la competencia.

Para Amazon, ScraperAPI facilita la extracción de datos a gran escala, sin pasar por la tecnología anti-scraping de Amazon. Proporciona una guía para extraer datos de Amazon utilizando Python Scrapy y ScraperAPI, y presenta una función de análisis automático que permite la recopilación de datos JSON de Amazon utilizando un punto final API estándar, devolviendo toda la información relevante en un formato estructurado.

6. Canalización de datos

La función Data Pipeline de ScraperAPI le permite automatizar proyectos de extracción de datos a gran escala sin escribir una sola línea de código.

Este Código bajo La solución reduce la necesidad de codificación y mantenimiento complejos de su propio raspador, lo que reduce los recursos y costos de ingeniería.

Con Data Pipeline, puede programar la recopilación automática de datos en hasta 10,000 XNUMX URL, lo que lo hace ideal para gestionar grandes proyectos de extracción de datos.

Le proporciona control total sobre cómo y dónde obtener sus datos, permitiéndole enviar datos directamente a cualquier carpeta de su aplicación, espacio de almacenamiento de documentos o email.

Además de esto, la función Data Pipeline también ofrece integraciones de webhooks, lo que elimina la necesidad de realizar descargas manuales o copiar y pegar.

Cupón exclusivo ScraperAPI 2024

10% de descuento en cupón ScraperAPI

EXCLUSIVO PROGRAMA

Utilice nuestro código de cupón exclusivo “affnico10”Y obtenga un 10% de descuento fijo en cualquier plan de suscripción ScraperAPI.

Ahorra 10%

Cabe destacar que puedes ahorrar un 20 % si implementas nuestro código de cupón "affnico10”con facturación anual, es decir; 10% con nuestro código de descuento + 10% con la facturación anual de ScraperAPI.

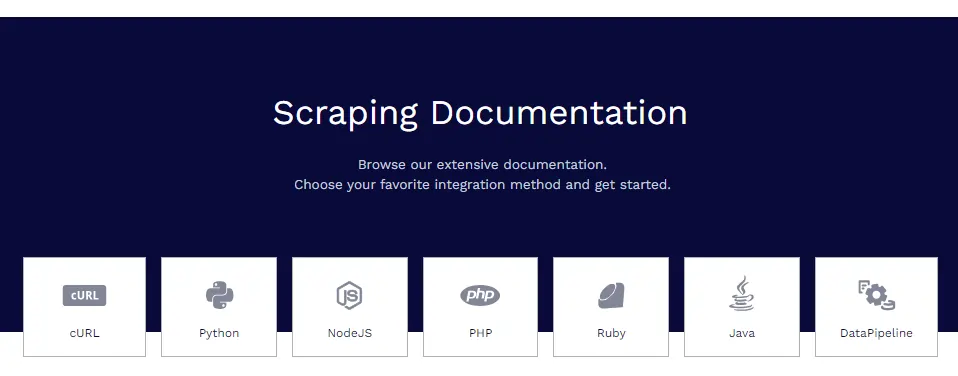

Documentación de ScraperAPI

ScraperAPI tiene documentación extensa y bien organizada que cubre todas sus características en profundidad con ejemplos de código en Python, Node.js, Ruby, PHP y más.

Algunos de los recursos de documentación útiles son:

- Primeros pasos: instalación, autenticación y primera llamada a la API.

- Extracción de datos estructurados: extracción de datos estructurados de comercio electrónico, anuncios clasificados, directorios, etc.

- Servicios de Google: guías para extraer Google Shopping, Google Maps, Google Flights y más.

- Canalizaciones de datos: configuración de canalizaciones de scraping automatizadas.

- Formato de respuesta: detalles sobre la estructura de salida JSON.

Los documentos contienen todo lo que necesita para dominar la extracción de datos con ScraperAPI.

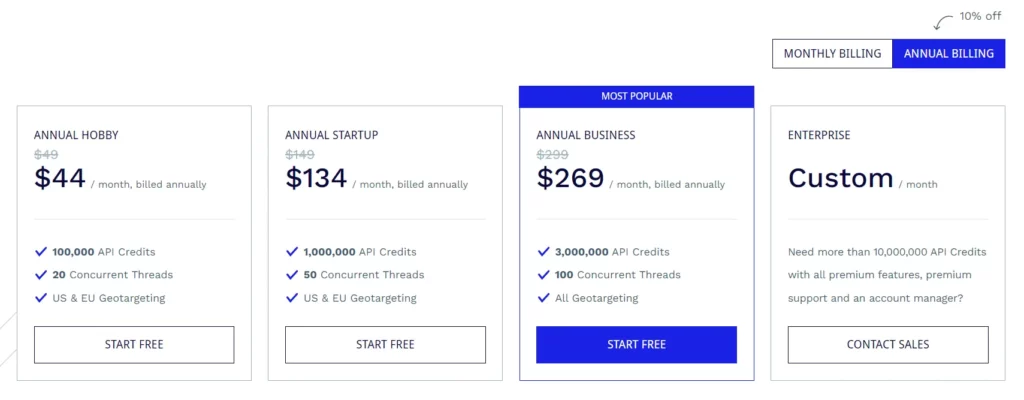

Planes de suscripción a ScraperAPI

Plan Hobby ($49/mes)

- 100,000 créditos API

- 20 hilos simultáneos

- Orientación geográfica en EE. UU. y la UE

Plan de inicio ($ 149 / mes)

- 1,000,000 créditos API

- 50 hilos simultáneos

- Orientación geográfica en EE. UU. y la UE

Plan de Negocios ($299/mes)

- 3,000,000 créditos API

- 100 hilos simultáneos

- Todas las opciones de orientación geográfica

Plan empresarial (precio personalizado)

- Plan personalizado por más de 10,000,000 de créditos API.

- Funciones premium, soporte premium y un administrador de cuentas dedicado.

Todos los planes vienen con características como representación de JavaScript, proxies premium, análisis automático de JSON, rotación de proxy inteligente, soporte de encabezado personalizado, ancho de banda ilimitado, reintentos automáticos, agentes de usuario móviles y de escritorio, garantía de tiempo de actividad del 99.9%, soporte de sesión personalizada, CAPTCHA y anti-bot. Detección y soporte profesional.

ScraperAPI también ofrece una prueba gratuita que incluye 5,000 créditos API durante 7 días.

Algunos recursos gratuitos de ScraperAPI

Además de la API, ScraperAPI también ofrece muchos recursos gratuitos para aprender a web scraping:

Centro de aprendizaje de web scraping

El Web Scraping Learning Hub contiene guías y tutoriales gratuitos para dominar el web scraping con Python y otros lenguajes.

Libros Electrónicos

ScraperAPI ha publicado útiles libros electrónicos gratuitos como “Web Scraping: The Basics Explicación” que enseñan los fundamentos del web scraping.

Webinars

Organizan seminarios web gratuitos sobre temas como "Extracción de sitios web de JavaScript", "Construcción de canales de datos", etc., que brindan consejos prácticos.

Proyectos de demostración

Los proyectos de demostración incluyen scripts de web scraping completamente codificados para tareas de scraping del mundo real de las que puede aprender.

Blog

API de raspador blog contiene tutoriales y artículos sobre las mejores prácticas de web scraping. Estos recursos gratuitos son invaluables para dominar el web scraping sin costo alguno. Complementan el API bien.

Preguntas frecuentes

¿ScraperAPI maneja servidores proxy y navegadores?

Sí, ScraperAPI gestiona una red distribuida de servidores proxy y navegadores automáticamente en segundo plano. No necesita preocuparse en absoluto por los proxy.

¿Puedo extraer datos detrás de los inicios de sesión?

Sí, ScraperAPI admite la extracción de datos detrás de los inicios de sesión pasando cookies en la solicitud de API para mantener las sesiones.

¿ScraperAPI se integra con Python?

Sí, ScraperAPI proporciona una biblioteca de Python que hace que la integración sea perfecta. También están disponibles bibliotecas para Node.js, Ruby, PHP, etc.

¿Puedo eliminar sitios web de JavaScript?

Definitivamente, los navegadores sin cabeza de ScraperAPI procesan JavaScript antes del scraping, por lo que los sitios JS no son un problema.

Concluyendo la revisión de ScraperAPI

Después de utilizar ampliamente ScraperAPI en mis diversos proyectos, puedo dar fe de su calidad y confiabilidad.

Para mis necesidades de web scraping, ScraperAPI cumple todos los requisitos. He probado competidores como Apify, Octoparse, ParseHub, etc., pero considero que ScraperAPI es el mejor en términos de características, conveniencia y precio.

Recomiendo encarecidamente ScraperAPI a cualquier individuo, equipo o empresa que necesite extraer datos web a escala. Seguramente le ahorrará horas de trabajo complejo de codificación y configuración para que pueda concentrarse en obtener información a partir de los datos.

Quick Links:

- Revisión de HilltopAds 2023: toda la red de alto CPM de GEO ya está aquí

- Revisión de Zeydoo 2023: Maximice sus ganancias con Zeydoo

- Los 8 mejores navegadores Antidetect para afiliados de 2023 (gratis y de pago)

- Minea Review 2023: una herramienta avanzada de investigación de productos (cupones y códigos promocionales de Minea)

Afiliación Divulgación: Esta publicación puede contener algunos enlaces de afiliados, lo que significa que podemos recibir una comisión si compra algo que recomendamos sin costo adicional para usted (¡ninguno en absoluto!)

![Writesonic Review 2024: la herramienta de redacción publicitaria definitiva [pros y contras] 11 Writesonic Review 2024: la herramienta de redacción publicitaria definitiva [pros y contras]](https://bloggingeclipse.com/wp-content/uploads/2022/03/Writesonic-Review-1024x512.webp)