Saya telah menggunakan berbagai alat pengikis web untuk a beberapa tahun sekarang untuk mengumpulkan data untuk laporan analitik saya.

Baru-baru ini, saya menemukan ScraperAPI dan sangat terkesan dengan kemampuannya.

Sekarang dalam ulasan rinci ScraperAPI ini, saya akan berbagi pengalaman pribadi saya menggunakan ScraperAPI, menjelaskan semua fitur utamanya, a langkah-demi-langkah panduan untuk menggunakannya, dan juga memberikan info tentang beberapa sumber daya gratis ditawarkan oleh ScraperAPI.

Mengapa Anda Membutuhkan Alat Pengikis Web?

Jika Anda berada dalam pekerjaan di mana Anda secara rutin perlu mengumpulkan data dari berbagai situs web untuk disertakan dalam laporan analitik yang Anda buat.

Mengekstraksi secara manual data dari situs web bisa membosankan dan memakan waktu. Alat pengikis web mengotomatiskan proses ini dengan mengekstraksi data dari halaman web secara terprogram.

Jika Anda mencari alat pengikis web canggih yang dapat membantu Anda mengumpulkan semua jenis data secara efisien e-commerce situs, situs ulasan, iklan baris, hasil mesin pencari halaman, dan banyak lagi. Hal-hal utama yang Anda butuhkan adalah:

Setelah menguji banyak alat, akhirnya saya menemukan ScraperAPI yang memenuhi semua persyaratan saya dan juga dapat bermanfaat bagi Anda. Sekarang mari kita lihat ulasan rinci tentang ScraperAPI.

Apa itu ScraperAPI?

API pengikis adalah API pengikisan web yang memungkinkan Anda mengekstrak data dari hampir semua situs web menggunakan panggilan REST API.

Ini menangani semua kerumitan seperti web scraping proxy, browser, CAPTCHA, dll. di belakang layar sehingga Anda dapat fokus hanya untuk mendapatkan data yang Anda perlukan.

ScraperAPI didirikan pada 2018 dan dengan cepat menjadi salah satu yang paling populer dan dapat diandalkan kerokan web jasa.

Alasan utama popularitasnya adalah ekstraksi data yang sederhana dan cepat menggunakan panggilan API, pengikisan asinkron yang kuat untuk pengumpulan data skala besar, Proksi bawaan dan penyelesaian CAPTCHA untuk pengikisan yang lancar, serta dokumentasi dan dukungan integrasi yang ekstensif.

Menurut pengalaman saya, ScraperAPI memecahkan dua masalah terbesar dalam web scraping – kecepatan dan skala. Ini memungkinkan saya mengekstrak data dari ribuan halaman web per jam tanpa kegagalan apa pun.

Penawaran Utama ScraperAPI

ScraperAPI menawarkan berbagai solusi dan fitur untuk Web Scraping yang mudah. Berikut beberapa kemampuannya yang paling berguna:

1. Layanan Pengikis Async

Layanan Scraper Async ScraperAPI memungkinkan pekerjaan scraping web skala besar dilakukan secara bersamaan dengan tingkat keberhasilan 99.99%.

Ia menggunakan mekanisme canggih untuk melewati sistem anti-scraping dan mengembalikan data yang diminta melalui panggilan API sederhana.

Scraper async mengirimkan pekerjaan melalui titik akhir async.scraperapi.com. Ini kemudian memanfaatkan Mesin belajar dan analisis statistik untuk menentukan kombinasi optimal IP, header, penyelesaian CAPTCHA, dan konfigurasi lainnya untuk memfasilitasi pengikisan situs web yang paling sulit sekalipun.

Pengguna dapat menyalin jutaan URL tanpa mengatur batas waktu atau mencoba ulang sendiri – scraper asinkron menangani semuanya secara otomatis. Hasil dikirim kembali melalui status URL atau webhook segera setelah pengikisan selesai.

Manfaat utama termasuk bawaan Rendering JavaScript, penargetan geografis, rotasi IP otomatis, penguraian data terstruktur, dan penyelesaian CAPTCHA.

Scraper async menghadirkan semua kekuatan API tradisional ScraperAPI dengan kemampuan tambahan untuk mengikis halaman tanpa batas secara bersamaan.

Scraper asinkron sangat ideal untuk proyek scraping berskala besar yang memerlukan data dari jutaan URL. Mekanisme otomatis dan keandalannya menjadikannya sempurna bagi mereka yang perlu membuat situs web sulit dalam skala besar.

2. Render JavaScript

Banyak situs web saat ini sangat bergantung pada JavaScript untuk merendernya Konten. Pencakar normal tidak dapat mengekstrak data dari konten yang dihasilkan JavaScript.

Yang mengesankan, browser tanpa kepala ScraperAPI merender JavaScript dengan cepat sebelum melakukan scraping. Hal ini memungkinkan pengumpulan data dengan lancar bahkan dari situs JavaScript yang paling rumit sekalipun.

3. Pemecahan CAPTCHA

CAPTCHA dapat memblokir scraper mengakses data. ScraperAPI sudah ada di dalamnya OCR kemampuan untuk menyelesaikan CAPTCHA secara otomatis secara real-time. Ini melewati CAPTCHA dengan mudah tanpa pekerjaan manual apa pun.

4. Data Terstruktur

ScraperAPI dapat mengekstrak data terstruktur seperti info produk, data ulasan, hasil pencarian, dll, dan keluarannya JSON Format.

Data terstruktur ini mudah digunakan untuk analisis dan aplikasi pembelajaran mesin tanpa memerlukan pembersihan data.

Misalnya, saya menggunakan ScraperAPI untuk mengekstrak 5000 Amazon daftar produk dengan informasi terstruktur lengkap seperti judul, peringkat, harga, dll. dalam satu panggilan API.

5. Pengikisan Google dan Amazon

ScraperAPI memberikan solusi khusus untuk mengambil data dari Google dan Amazon. Ini memungkinkan pengguna mengekstrak data terstruktur dari Google Shopping, Google Search, Amazon Product Advertising API, dan banyak lagi.

Ini sangat berharga bagi saya untuk mendapatkan daftar produk, hasil pencarian, ulasan, data harga, dll. dari Amazon dan Google.

Bagi Google, ia dapat mengumpulkan data dari berbagai permintaan pencarian dan mengubahnya menjadi data JSON terstruktur, yang dapat digunakan untuk berbagai tujuan seperti riset pasar, Alat SEO, dan pemantauan pesaing.

Bagi Amazon, ScraperAPI membuat pengambilan data skala besar menjadi lebih mudah, melewati teknologi anti-scraping Amazon. Ini memberikan panduan untuk mengikis data Amazon menggunakan Python Scrapy dan ScraperAPI, dan dilengkapi fungsi Parsing Otomatis yang memungkinkan pengumpulan data JSON dari Amazon menggunakan titik akhir API standar, mengembalikan semua informasi relevan dalam format terstruktur.

6. Saluran Data

Fitur Data Pipeline ScraperAPI memungkinkan Anda mengotomatiskan proyek pengumpulan data berskala besar tanpa menulis satu baris kode pun.

Kredensial mikro kode rendah solusi ini mengurangi kebutuhan akan pengkodean yang rumit dan pemeliharaan scraper Anda sendiri, sehingga mengurangi sumber daya dan biaya teknik.

Dengan Data Pipeline, Anda dapat menjadwalkan pengumpulan data otomatis hingga 10,000 URL, sehingga ideal untuk mengelola proyek ekstraksi data besar.

Ini memberi Anda kendali penuh atas bagaimana dan di mana mendapatkan data Anda, memungkinkan Anda mengirim data langsung ke folder mana pun di aplikasi Anda, ruang penyimpanan dokumen, atau e-mail.

Selain itu, fitur Data Pipeline juga menawarkan integrasi webhook, sehingga menghilangkan kebutuhan pengunduhan manual atau copy-paste.

Kupon ScraperAPI Eksklusif 2024

DISKON 10% Kupon ScraperAPI

eksklusif

Gunakan kode kupon eksklusif kami “affnico10” dan dapatkan diskon tetap 10% untuk paket berlangganan ScraperAPI apa pun.

Simpan% 10

Yang perlu diperhatikan, Anda dapat menghemat 20% jika menerapkan kode kupon kami “affnico10” dengan penagihan tahunan yaitu; 10% dengan kode diskon kami + 10% dengan tagihan tahunan ScraperAPI.

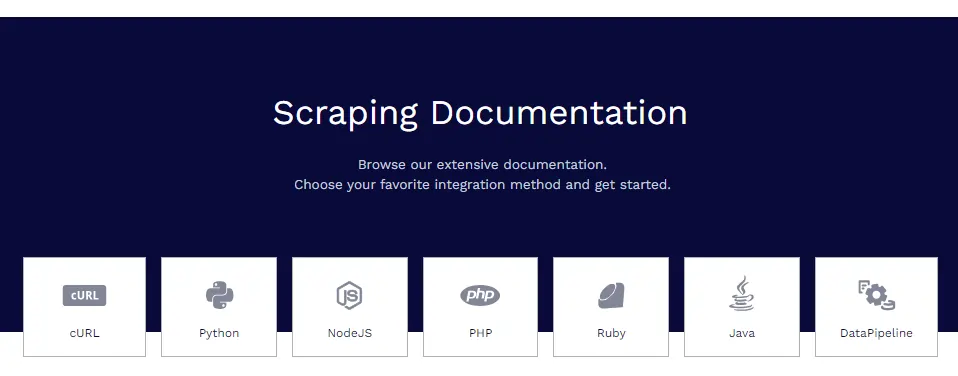

Dokumentasi ScraperAPI

ScraperAPI memiliki dokumentasi yang luas dan terorganisir dengan baik yang mencakup semua fiturnya secara mendalam dengan contoh kode dalam Python, Node.js, Ruby, PHP, dan banyak lagi.

Beberapa sumber dokumentasi yang bermanfaat adalah:

- Memulai – Instalasi, otentikasi, dan panggilan API pertama.

- Mengekstraksi Data Terstruktur – Mengikis data terstruktur dari e-niaga, iklan baris, direktori, dll.

- Layanan Google – Panduan untuk menyalin Google Belanja, Google Maps, Google Penerbangan, dan lainnya.

- Saluran Data – Menyiapkan saluran pengikisan otomatis.

- Format Respons – Detail tentang struktur keluaran JSON.

Dokumen tersebut berisi semua yang Anda perlukan untuk menjadi mahir dalam mengumpulkan data dengan ScraperAPI.

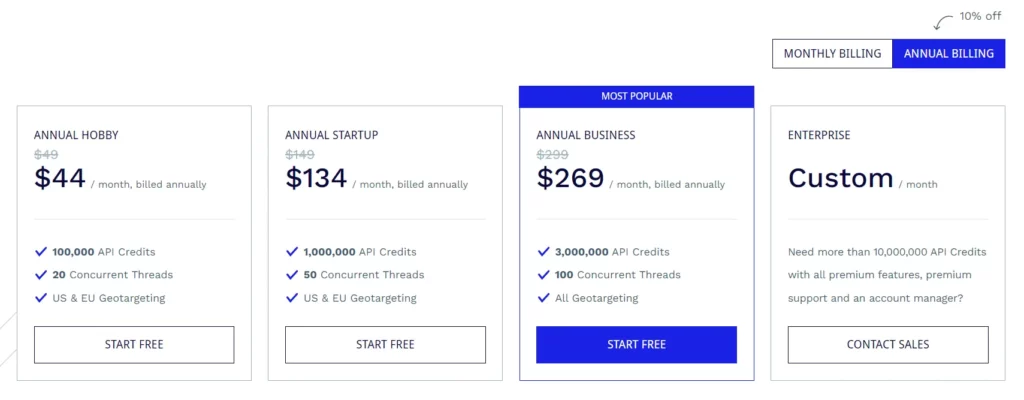

Paket Berlangganan ScraperAPI

Paket Hobi ($49/bulan)

- 100,000 kredit API

- 20 utas bersamaan

- Penargetan geografis AS & UE

Rencana Memulai ($149/bulan)

- 1,000,000 kredit API

- 50 utas bersamaan

- Penargetan geografis AS & UE

Paket Bisnis ($299/bulan)

- 3,000,000 kredit API

- 100 utas bersamaan

- Semua opsi penargetan geografis

Paket Perusahaan (Harga Khusus)

- Paket khusus untuk lebih dari 10,000,000 kredit API.

- Fitur premium, dukungan premium, dan pengelola akun khusus.

Semua paket dilengkapi dengan fitur seperti rendering JavaScript, Proksi premium, penguraian otomatis JSON, Rotasi proksi pintar, Dukungan header khusus, Bandwidth tidak terbatas, Percobaan ulang otomatis, Agen pengguna desktop & seluler, jaminan waktu aktif 99.9%, dukungan sesi khusus, CAPTCHA & anti-bot deteksi dan dukungan Profesional.

ScraperAPI juga menyediakan Uji Coba Gratis yang mencakup 5,000 kredit API selama 7 hari.

Beberapa Sumber Daya Gratis dari ScraperAPI

Selain API, ScraperAPI juga menawarkan banyak sumber daya gratis untuk mempelajari web scraping:

Pusat Pembelajaran Pengikisan Web

Grafik Web Scraping Learning Hub berisi tutorial dan panduan gratis untuk menguasai web scraping dengan Python dan bahasa lainnya.

Ebooks

ScraperAPI telah menerbitkan eBook gratis yang bermanfaat seperti “Web Scraping: Penjelasan Dasar-Dasar” yang mengajarkan dasar-dasar web scraping.

Webinars

Mereka menyelenggarakan webinar gratis tentang topik seperti “Mengikis Situs Web JavaScript”, “Membangun Saluran Data”, dll. yang memberikan tip yang dapat ditindaklanjuti.

Proyek Demo

Proyek demo mencakup skrip pengikisan web berkode lengkap untuk tugas pengikisan dunia nyata yang dapat Anda pelajari.

Blog

ScraperAPI blog berisi tutorial dan artikel tentang praktik terbaik web scraping. Sumber daya gratis ini sangat berharga untuk menguasai web scraping tanpa biaya. Mereka melengkapi API baik.

Tanya Jawab Umum (FAQ)

Apakah ScraperAPI menangani proxy dan browser?

Ya, ScraperAPI mengelola jaringan proxy dan browser terdistribusi secara otomatis di latar belakang. Anda tidak perlu khawatir tentang proxy sama sekali.

Bisakah saya mengikis data di balik login?

Ya, ScraperAPI mendukung pengambilan data di belakang login dengan meneruskan cookie dalam permintaan API untuk mempertahankan sesi.

Apakah ScraperAPI terintegrasi dengan Python?

Ya, ScraperAPI menyediakan pustaka Python yang membuat integrasi menjadi lancar. Library untuk Node.js, Ruby, PHP, dll juga tersedia.

Bisakah saya mengikis situs web JavaScript?

Tentu saja, browser tanpa kepala ScraperAPI merender JavaScript sebelum melakukan scraping sehingga situs JS tidak menjadi masalah.

Mengakhiri Tinjauan ScraperAPI

Setelah banyak menggunakan ScraperAPI di berbagai proyek saya, saya yakin dapat menjamin kualitas dan keandalannya.

Untuk kebutuhan pengikisan web saya, ScraperAPI memenuhi semua kebutuhan. Saya telah mencoba pesaing seperti Apify, Octoparse, ParseHub, dll. tetapi menurut saya ScraperAPI adalah yang terbaik dalam hal fitur, kenyamanan, dan harga.

Saya sangat merekomendasikan ScraperAPI kepada individu, tim, atau perusahaan mana pun yang perlu mengekstrak data web dalam skala besar. Ini pasti akan menghemat waktu berjam-jam pekerjaan pengkodean dan pengaturan yang rumit sehingga Anda dapat fokus untuk mendapatkan wawasan dari data.

Link Cepat:

- Ulasan HilltopAds 2023: Semua Jaringan CPM Tinggi GEO Ada Di Sini

- Ulasan Zeydoo 2023: Maksimalkan Penghasilan Anda dengan Zeydoo

- 8 Browser Antideteksi Terbaik untuk Afiliasi 2023 (Gratis & Berbayar)

- Ulasan Minea 2023: Alat Riset Produk Canggih (Kupon Minea & Kode Promo)

Bergabung Penyingkapan: Posting ini mungkin berisi beberapa tautan afiliasi, yang berarti kami dapat menerima komisi jika Anda membeli sesuatu yang kami rekomendasikan tanpa biaya tambahan untuk Anda (tidak ada sama sekali!)

![Ulasan Writesonic 2024: Alat Copywriting Terbaik [Pro & Kontra] 11 Ulasan Writesonic 2024: Alat Copywriting Terbaik [Pro & Kontra]](https://bloggingeclipse.com/wp-content/uploads/2022/03/Writesonic-Review-1024x512.webp)