Ho utilizzato vari strumenti di web scraping per a pochi anni ora per raccogliere dati per i miei report di analisi.

Di recente mi sono imbattuto in ScraperAPI e sono rimasto molto colpito dalle sue capacità.

Ora, in questa recensione dettagliata di ScraperAPI, condividerò la mia esperienza personale utilizzando ScraperAPI, spiegherò tutte le sue caratteristiche principali, a passo-passo guida per usarlo e fornire anche informazioni su alcuni risorse gratuite offerto da ScraperAPI.

Perché hai bisogno di uno strumento di web scraping?

Se svolgi un lavoro in cui devi regolarmente raccogliere dati da diversi siti Web da includere nei report di analisi che crei.

Estrazione manuale dati dai siti Web può essere noioso e richiedere molto tempo. Gli strumenti di web scraping automatizzano questo processo estraendo dati in modo programmatico dalle pagine web.

Se stavi cercando un potente strumento di web scraping che potesse aiutarti a raccogliere in modo efficiente tutti i tipi di dati da e-commerce siti, siti di recensioni, annunci, risultati del motore di ricerca pagine e altro ancora. Le cose fondamentali di cui avevi bisogno erano:

Dopo aver testato molti strumenti, ho finalmente trovato ScraperAPI che ha soddisfatto tutti i miei requisiti e può essere utile anche a te. Ora diamo un'occhiata a una recensione dettagliata di ScraperAPI.

Cos'è ScraperAPI?

API raschietto è un'API di web scraping che ti consente di estrarre dati da quasi tutti i siti Web utilizzando chiamate API REST.

Gestisce tutte le complessità del web scraping come proxy, browser, CAPTCHA, ecc. dietro le quinte in modo che tu possa concentrarti solo su come ottenere i dati di cui hai bisogno.

ScraperAPI è stata fondata nel 2018 ed è rapidamente diventato uno dei più popolari e affidabili raschiatura del web servizi.

I motivi principali della sua popolarità sono l'estrazione dei dati semplice e veloce tramite chiamate API, il potente scraping asincrono per la raccolta di dati su larga scala, i proxy integrati e la risoluzione di CAPTCHA per lo scraping senza soluzione di continuità, nonché un'ampia documentazione e supporto per l'integrazione.

Nella mia esperienza, ScraperAPI risolve i due maggiori punti critici del web scraping: velocità e scalabilità. Mi ha permesso di estrarre dati da migliaia di pagine web all'ora senza errori di scraping.

Offerte chiave di ScraperAPI

ScraperAPI offre varie soluzioni e funzionalità per il Web Scraping senza sforzo. Ecco alcune delle sue funzionalità più utili:

1. Servizio raschiatore asincrono

Il servizio Async Scraper di ScraperAPI consente di eseguire contemporaneamente lavori di web scraping su larga scala con una percentuale di successo del 99.99%.

Utilizza meccanismi avanzati per aggirare i sistemi anti-scraping e restituire i dati richiesti tramite una semplice chiamata API.

Lo scraper asincrono invia lavori tramite l'endpoint async.scraperapi.com. Quindi fa leva machine learning e analisi statistiche per determinare la combinazione ottimale di IP, intestazioni, risoluzione CAPTCHA e altre configurazioni per facilitare lo scraping anche dei siti Web più difficili.

Gli utenti possono acquisire milioni di URL senza gestire i timeout o riprovare da soli: lo scraper asincrono gestisce tutto automaticamente. I risultati vengono inviati tramite uno stato URL o webhook non appena lo scraping è stato completato.

I principali vantaggi includono la funzionalità integrata Rendering JavaScript, targeting geografico, rotazione IP automatica, analisi dei dati strutturati e risoluzione dei CAPTCHA.

Lo scraper asincrono offre tutta la potenza dell'API tradizionale di ScraperAPI con la possibilità aggiuntiva di raschiare un numero illimitato di pagine contemporaneamente.

Lo scraper asincrono è ideale per progetti di scraping su larga scala che richiedono dati da milioni di URL. I suoi meccanismi automatizzati e la sua affidabilità lo rendono perfetto per coloro che hanno bisogno di analizzare siti Web difficili su larga scala.

2. Rendering JavaScript

Molti siti Web oggi fanno molto affidamento su JavaScript per il rendering contenuto. I normali raschiatori non possono estrarre dati dal contenuto generato da JavaScript.

Sorprendentemente, i browser headless di ScraperAPI eseguono il rendering di JavaScript al volo prima dello scraping. Ciò consente di raccogliere dati senza problemi anche dai siti JavaScript più complessi.

3. Risoluzione del CAPTCHA

I CAPTCHA possono impedire agli scraper di accedere ai dati. ScraperAPI è integrato OCR funzionalità per risolvere i CAPTCHA automaticamente in tempo reale. Questo aggira i CAPTCHA senza sforzo e senza alcun lavoro manuale.

4. Dati strutturati

ScraperAPI può estrarre dati strutturati come informazioni sul prodotto, dati di revisione, risultati di ricerca, ecc JSON formato.

Questi dati strutturati sono facilmente utilizzabili per applicazioni di analisi e apprendimento automatico senza la necessità di pulire i dati.

Ad esempio, ho utilizzato ScraperAPI per estrarre 5000 Amazon elenchi di prodotti con informazioni strutturate complete come titolo, valutazione, prezzo, ecc. in un'unica chiamata API.

5. Raschiamento di Google e Amazon

ScraperAPI fornisce soluzioni specializzate per lo scraping dei dati da Google e Amazon. Consente agli utenti di estrarre dati strutturati da Google Shopping, Ricerca Google, API Amazon Product Advertising e altro ancora.

Questo è stato prezioso per me ottenere elenchi di prodotti, risultati di ricerca, recensioni, dati sui prezzi, ecc. da Amazon e Google.

Per Google, può raccogliere dati da numerose query di ricerca e convertirli in dati JSON strutturati, che possono essere utilizzati per vari scopi come ricerche di mercato, Strumenti SEOe monitoraggio della concorrenza.

Per Amazon, ScraperAPI semplifica lo scraping dei dati su larga scala, bypassando la tecnologia anti-scraping di Amazon. Fornisce una guida per lo scraping dei dati Amazon utilizzando Python Scrapy e ScraperAPI e presenta una funzione di analisi automatica che consente la raccolta di dati JSON da Amazon utilizzando un endpoint API standard, restituendo tutte le informazioni rilevanti in un formato strutturato.

6. Conduttura dei dati

La funzionalità Data Pipeline di ScraperAPI ti consente di automatizzare progetti di scraping di dati su larga scala senza scrivere una singola riga di codice.

La sezione codice basso La soluzione riduce la necessità di codifica e manutenzione complesse del proprio raschiatore, riducendo così le risorse e i costi di progettazione.

Con Data Pipeline puoi pianificare la raccolta automatica dei dati su un massimo di 10,000 URL, rendendolo ideale per la gestione di progetti di estrazione dati di grandi dimensioni.

Ti fornisce il controllo completo su come e dove ottenere i tuoi dati, permettendoti di inviare i dati direttamente a qualsiasi cartella nella tua applicazione, spazio di archiviazione dei documenti o email.

Oltre a questi, la funzionalità Data Pipeline offre anche integrazioni webhook, eliminando la necessità di download manuali o copia-incolla.

Coupon esclusivo ScraperAPI 2024

Coupon SCONTO DEL 10% su ScraperAPI

esclusivo

Utilizza il nostro codice coupon esclusivo “affnico10" e ottieni uno sconto fisso del 10% su qualsiasi piano di abbonamento ScraperAPI.

Salva 10%

È interessante notare che puoi risparmiare il 20% se implementi il nostro codice coupon “affnico10" con fatturazione annuale, vale a dire; 10% con il nostro codice sconto + 10% con fatturazione annuale di ScraperAPI.

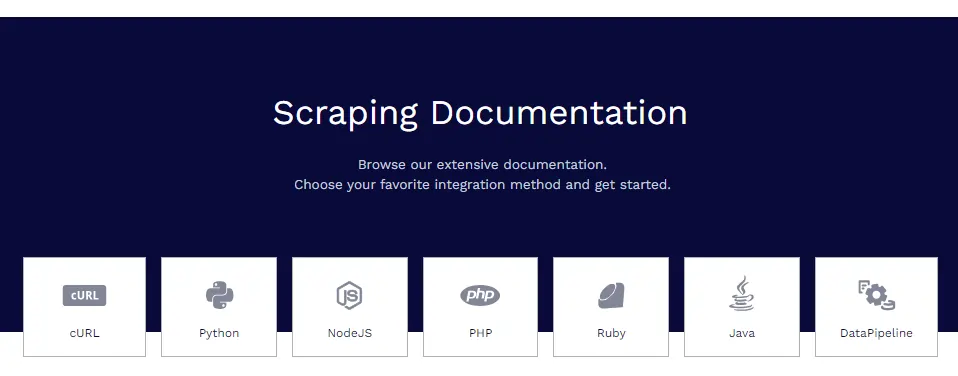

Documentazione ScraperAPI

ScraperAPI dispone di una documentazione ampia e ben organizzata che copre tutte le sue funzionalità in modo approfondito con esempi di codice in Python, Node.js, Ruby, PHP e altro.

Alcune delle risorse di documentazione utili sono:

- Guida introduttiva: installazione, autenticazione e prima chiamata API.

- Estrazione di dati strutturati – Estrazione di dati strutturati da e-commerce, annunci economici, directory, ecc.

- Servizi Google: guide per lo scraping di Google Shopping, Google Maps, Google Voli e altro ancora.

- Pipeline di dati: impostazione di pipeline di scraping automatizzate.

- Formato della risposta: dettagli sulla struttura di output JSON.

I documenti contengono tutto ciò di cui hai bisogno per diventare esperto nello scraping dei dati con ScraperAPI.

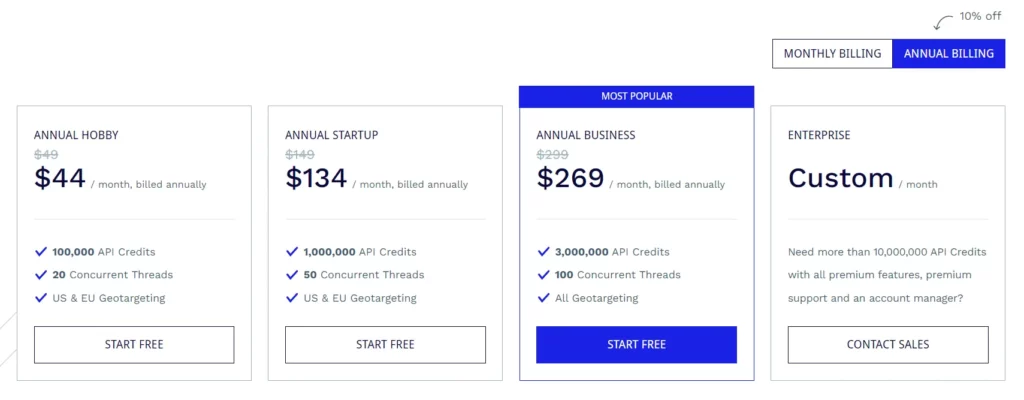

Piani di abbonamento ScraperAPI

Piano hobby ($ 49 / mese)

- 100,000 crediti API

- 20 thread simultanei

- Targeting geografico per Stati Uniti e UE

Piano di avvio ($ 149/mese)

- 1,000,000 crediti API

- 50 thread simultanei

- Targeting geografico per Stati Uniti e UE

Piano aziendale ($ 299/mese)

- 3,000,000 crediti API

- 100 thread simultanei

- Tutte le opzioni di targeting geografico

Piano aziendale (prezzi personalizzati)

- Piano personalizzato per oltre 10,000,000 di crediti API.

- Funzionalità premium, supporto premium e un account manager dedicato.

Tutti i piani sono dotati di funzionalità come rendering JavaScript, proxy premium, analisi automatica JSON, rotazione proxy intelligente, supporto intestazione personalizzata, larghezza di banda illimitata, tentativi automatici, agenti utente desktop e mobili, garanzia di uptime del 99.9%, supporto sessione personalizzata, CAPTCHA e anti-bot rilevamento e supporto professionale.

ScraperAPI fornisce anche una prova gratuita che include 5,000 crediti API per 7 giorni.

Alcune risorse gratuite da ScraperAPI

Oltre all'API, ScraperAPI offre anche molte risorse gratuite per l'apprendimento del web scraping:

Hub di apprendimento del web scraping

I Web Scraping Learning Hub contiene tutorial e guide gratuiti per padroneggiare il web scraping con Python e altri linguaggi.

Ebooks

ScraperAPI ha pubblicato utili ebook gratuiti come "Web Scraping: The Basics Explained" che insegnano i fondamenti del web scraping.

Webinars

Ospitano webinar gratuiti su argomenti come "Scraping di siti Web JavaScript", "Creazione di pipeline di dati" ecc. Che forniscono suggerimenti attuabili.

Progetti dimostrativi

I progetti demo includono script di web scraping completamente codificati per attività di scraping reali da cui puoi imparare.

Blog

ScraperAPI blog contiene tutorial e articoli sulle migliori pratiche di web scraping. Queste risorse gratuite sono preziose per padroneggiare il web scraping senza alcun costo. Completano il API bene.

Domande frequenti

ScraperAPI gestisce proxy e browser?

Sì, ScraperAPI gestisce automaticamente in background una rete distribuita di proxy e browser. Non devi preoccuparti affatto dei proxy.

Posso recuperare i dati dietro gli accessi?

Sì, ScraperAPI supporta lo scraping dei dati dietro gli accessi passando i cookie nella richiesta API per mantenere le sessioni.

ScraperAPI si integra con Python?

Sì, ScraperAPI fornisce una libreria Python che rende l'integrazione perfetta. Sono disponibili anche librerie per Node.js, Ruby, PHP, ecc.

Posso raschiare siti Web JavaScript?

Sicuramente, i browser headless di ScraperAPI eseguono il rendering di JavaScript prima dello scraping, quindi i siti JS non rappresentano un problema.

Concludendo la revisione di ScraperAPI

Dopo aver utilizzato ampiamente ScraperAPI nei miei vari progetti, posso garantire con sicurezza la sua qualità e affidabilità.

Per le mie esigenze di web scraping, ScraperAPI soddisfa tutte le esigenze. Ho provato concorrenti come Apify, Octoparse, ParseHub, ecc. Ma ho trovato ScraperAPI il migliore in termini di funzionalità, comodità e prezzi.

Consiglio vivamente ScraperAPI a qualsiasi individuo, team o azienda che abbia bisogno di estrarre dati Web su larga scala. Ti farà sicuramente risparmiare ore di codifica complessa e lavoro di configurazione in modo che tu possa concentrarti sulla derivazione di approfondimenti dai dati.

Link veloci:

- Recensione HilltopAds 2023: la rete ad alto CPM di tutti i GEO è qui

- Recensione Zeydoo 2023: massimizza i tuoi guadagni con Zeydoo

- 8 migliori browser antirilevamento per affiliati 2023 (gratuiti e a pagamento)

- Minea Review 2023: uno strumento avanzato di ricerca sui prodotti (buoni Minea e codici promozionali)

Affiliazione Rivelazione: Questo post potrebbe contenere alcuni link di affiliazione, il che significa che potremmo ricevere una commissione se acquisti qualcosa che ti consigliamo senza costi aggiuntivi per te (nessuno!)

![Recensione Writesonic 2024: lo strumento di copywriting definitivo [Pro e contro] 11 Recensione Writesonic 2024: lo strumento di copywriting definitivo [Pro e contro]](https://bloggingeclipse.com/wp-content/uploads/2022/03/Writesonic-Review-1024x512.webp)