Ik heb verschillende webscraping-tools gebruikt voor a paar jaar nu om gegevens te verzamelen voor mijn analyserapporten.

Onlangs kwam ik ScraperAPI tegen en was diep onder de indruk van de mogelijkheden ervan.

In deze gedetailleerde ScraperAPI-recensie zal ik nu mijn persoonlijke ervaring met het gebruik van ScraperAPI delen, alle belangrijkste functies ervan uitleggen, een stap-voor-stap handleiding om het te gebruiken, en ook informatie over sommige te geven gratis middelen aangeboden door ScraperAPI.

Waarom heeft u een webscrapingtool nodig?

Als u een baan heeft waarbij u regelmatig gegevens van verschillende websites moet verzamelen om op te nemen in de analyserapporten die u maakt.

Handmatig extraheren gegevens van websites kan vervelend en tijdrovend zijn. Webscraping-tools automatiseren dit proces door programmatisch gegevens uit webpagina's te extraheren.

Als u op zoek was naar een krachtige tool voor webschrapen waarmee u op efficiënte wijze allerlei soorten gegevens kunt verzamelen e-commerce sites, recensiesites, advertenties, zoekmachine resultaten pagina's en meer. De belangrijkste dingen die je nodig had waren:

Na veel tools te hebben getest, heb ik eindelijk ScraperAPI gevonden die aan al mijn eisen voldeed en waar jij ook profijt van kunt hebben. Laten we nu eens kijken naar een gedetailleerd overzicht van ScraperAPI.

Wat is ScraperAPI?

SchraperAPI is een webscraping-API waarmee u gegevens van vrijwel elke website kunt extraheren met behulp van REST API-aanroepen.

Het behandelt alle complexiteiten van webscrapen, zoals proxies, browsers, CAPTCHA's, enz. achter de schermen, zodat u zich kunt concentreren op het verkrijgen van de gegevens die u nodig heeft.

ScraperAPI is opgericht in 2018 en is snel een van de meest populaire en betrouwbare geworden web schrapen services.

De belangrijkste redenen voor zijn populariteit zijn eenvoudige en snelle gegevensextractie met behulp van API-aanroepen, krachtige async-scraping voor grootschalige gegevensverzameling, ingebouwde proxy's en CAPTCHA-oplossingen voor naadloos schrapen, en uitgebreide documentatie- en integratieondersteuning.

In mijn ervaring lost ScraperAPI de twee grootste pijnpunten van webscrapen op: snelheid en schaal. Het heeft me in staat gesteld om gegevens uit duizenden webpagina's per uur te extraheren zonder enige scraping-fouten.

Het belangrijkste aanbod van ScraperAPI

ScraperAPI biedt verschillende oplossingen en functies voor moeiteloos webscrapen. Hier zijn enkele van de nuttigste mogelijkheden:

1. Asynchrone Scraper-service

Met de Async Scraper Service van ScraperAPI kunnen grootschalige webscraping-taken gelijktijdig worden uitgevoerd met een succespercentage van 99.99%.

Het maakt gebruik van geavanceerde mechanismen om anti-scraping-systemen te omzeilen en de gevraagde gegevens terug te sturen via een eenvoudige API-oproep.

De asynchrone scraper verzendt taken via het async.scraperapi.com-eindpunt. Het werkt dan op machine learning en statistische analyse om de optimale combinatie van IP's, headers, CAPTCHA-oplossingen en andere configuraties te bepalen om het scrapen van zelfs de moeilijkste websites te vergemakkelijken.

Gebruikers kunnen miljoenen URL's schrapen zonder zelf time-outs of nieuwe pogingen te beheren; de asynchrone scraper handelt dit allemaal automatisch af. Resultaten worden via een status teruggestuurd URL of webhook zodra het schrapen is voltooid.

De belangrijkste voordelen zijn onder meer ingebouwd JavaScript-weergave, geotargeting, automatische IP-rotatie, gestructureerde gegevensparsering en CAPTCHA-oplossing.

De asynchrone scraper biedt alle kracht van de traditionele API van ScraperAPI, met de extra mogelijkheid om tegelijkertijd een onbeperkt aantal pagina's te schrapen.

De asynchrone scraper is ideaal voor grootschalige scrapingprojecten waarvoor gegevens van miljoenen URL's nodig zijn. De geautomatiseerde mechanismen en betrouwbaarheid maken het perfect voor degenen die moeilijke websites op grote schaal moeten schrapen.

2. JavaScript-weergave

Veel websites zijn tegenwoordig sterk afhankelijk van JavaScript om weer te geven content. Normale scrapers kunnen geen gegevens extraheren uit door JavaScript gegenereerde inhoud.

Het is indrukwekkend dat de headless browsers van ScraperAPI JavaScript on-the-fly weergeven voordat ze worden geschraapt. Hierdoor kunnen gegevens naadloos worden verzameld van zelfs de meest complexe JavaScript-sites.

3. CAPTCHA oplossen

CAPTCHA's kunnen voorkomen dat scrapers toegang krijgen tot gegevens. ScraperAPI heeft ingebouwd OCR mogelijkheden om CAPTCHA's automatisch in realtime op te lossen. Hiermee worden CAPTCHA’s moeiteloos omzeild, zonder enig handmatig werk.

4. Gestructureerde gegevens

ScraperAPI kan gestructureerde gegevens zoals productinformatie, beoordelingsgegevens, zoekresultaten, enz. extraheren en uitvoeren JSON formaat.

Deze gestructureerde gegevens zijn direct bruikbaar voor analyse- en machine learning-toepassingen zonder dat gegevens moeten worden opgeschoond.

Ik heb bijvoorbeeld ScraperAPI gebruikt om 5000 Amazon te extraheren productvermeldingen met volledige gestructureerde informatie zoals titel, beoordeling, prijs, etc. in één enkele API-aanroep.

5. Google en Amazon schrapen

ScraperAPI biedt gespecialiseerde oplossingen voor het schrapen van gegevens van Google en Amazon. Hiermee kunnen gebruikers gestructureerde gegevens extraheren uit Google Shopping, Google Search, Amazon Product Advertising API en meer.

Dit is voor mij van onschatbare waarde geweest om productvermeldingen, zoekresultaten, recensies, prijsgegevens, enz. van Amazon en Google te krijgen.

Voor Google kan het gegevens uit talloze zoekopdrachten verzamelen en deze omzetten in gestructureerde JSON-gegevens, die voor verschillende doeleinden kunnen worden gebruikt, zoals marktonderzoek, SEO-toolsen monitoring van concurrenten.

Voor Amazon maakt ScraperAPI het grootschalige data-scrapen eenvoudiger, waarbij de anti-scraping-technologie van Amazon wordt omzeild. Het biedt een handleiding voor het scrapen van Amazon-gegevens met behulp van Python Scrapy en ScraperAPI, en beschikt over een Auto Parsing-functie waarmee JSON-gegevens van Amazon kunnen worden verzameld met behulp van een standaard API-eindpunt, waarbij alle relevante informatie in een gestructureerd formaat wordt geretourneerd.

6. Datapijplijn

Met de Data Pipeline-functie van ScraperAPI kunt u grootschalige gegevensschraapprojecten automatiseren zonder ook maar één regel code te schrijven.

Deze Lage code oplossing vermindert de noodzaak van complexe codering en onderhoud van uw eigen schraper, waardoor de technische middelen en kosten worden verminderd.

Met Data Pipeline kunt u automatische gegevensverzameling plannen voor maximaal 10,000 URL's, waardoor het ideaal is voor het beheren van grote gegevensextractieprojecten.

Het biedt u volledige controle over hoe en waar u uw gegevens kunt ophalen, waardoor u gegevens rechtstreeks naar elke map in uw toepassing, documentopslagruimte of email.

Daarnaast biedt de Data Pipeline-functie ook webhook-integraties, waardoor handmatige downloads of kopiëren en plakken overbodig worden.

Exclusieve ScraperAPI-coupon 2024

10% KORTING ScraperAPI-coupon

exclusief

Gebruik onze exclusieve couponcode “afnico10' en ontvang 10% korting op elk ScraperAPI-abonnement.

Bespaar 10%

Opmerkelijk is dat u 20% kunt besparen als u onze couponcode implementeert “afnico10” met jaarlijkse facturering, dwz; 10% met onze kortingscode + 10% met de jaarlijkse facturering van ScraperAPI.

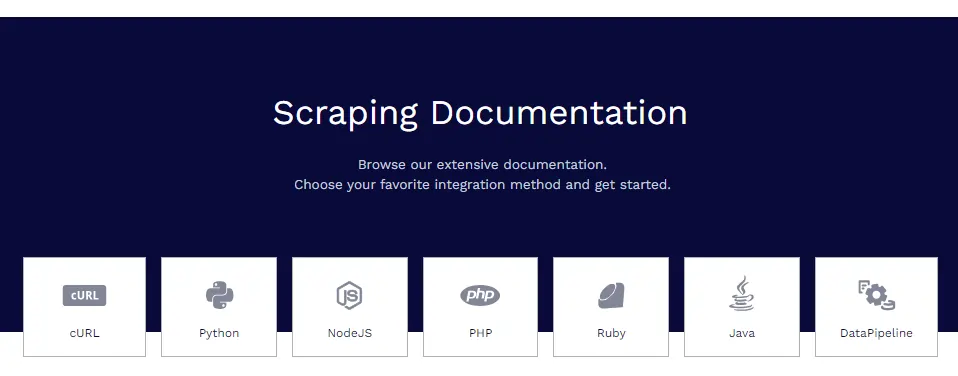

ScraperAPI-documentatie

ScraperAPI heeft uitgebreide en goed georganiseerde documentatie die alle functies diepgaand behandelt met codevoorbeelden in Python, Node.js, Ruby, PHP en meer.

Enkele van de nuttige documentatiebronnen zijn:

- Aan de slag – Installatie, authenticatie en eerste API-oproep.

- Gestructureerde gegevens extraheren – Gestructureerde gegevens uit e-commerce, advertenties, directory's, enz. schrapen.

- Google-services - Gidsen voor het scrapen van Google Shopping, Google Maps, Google Flights en meer.

- Data Pipelines – Het opzetten van geautomatiseerde scraping pipelines.

- Antwoordformaat – Details over de JSON-uitvoerstructuur.

De documenten bevatten alles wat u nodig heeft om vaardig te worden in het verzamelen van gegevens met ScraperAPI.

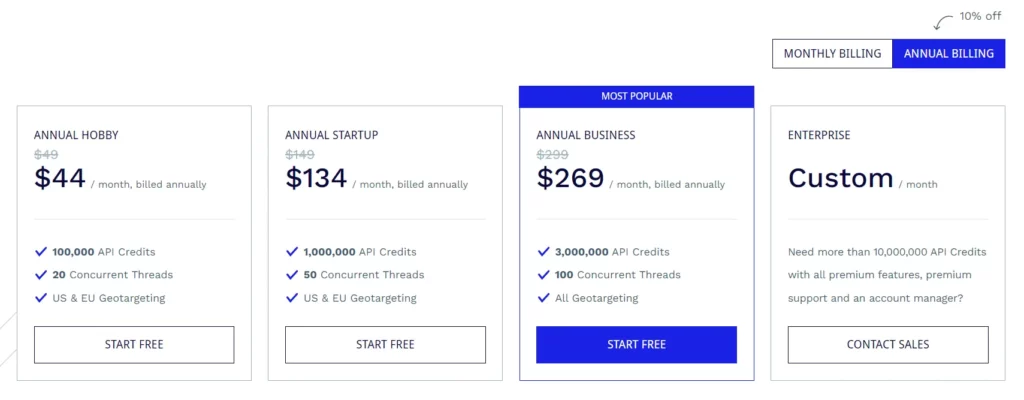

ScraperAPI-abonnementsplannen

Hobbyabonnement ($ 49/maand)

- 100,000 API-credits

- 20 gelijktijdige threads

- Geografische targeting in de VS en de EU

Opstartplan ($ 149 / maand)

- 1,000,000 API-credits

- 50 gelijktijdige threads

- Geografische targeting in de VS en de EU

Bedrijfsplan ($ 299 / maand)

- 3,000,000 API-credits

- 100 gelijktijdige threads

- Alle geotargetingopties

Enterprise-abonnement (aangepaste prijzen)

- Op maat gemaakt plan voor meer dan 10,000,000 API-credits.

- Premium-functies, premium-ondersteuning en een toegewijde accountmanager.

Alle abonnementen worden geleverd met functies zoals JavaScript-rendering, Premium-proxy's, automatische JSON-parsing, slimme proxy-rotatie, ondersteuning voor aangepaste headers, onbeperkte bandbreedte, automatische nieuwe pogingen, desktop- en mobiele user-agents, 99.9% uptime-garantie, ondersteuning voor aangepaste sessies, CAPTCHA en anti-bot detectie en professionele ondersteuning.

ScraperAPI biedt ook een gratis proefperiode met 5,000 API-credits gedurende 7 dagen.

Enkele gratis bronnen van ScraperAPI

Naast de API biedt ScraperAPI ook veel gratis bronnen voor het leren van webscrapen:

Webscraping-leercentrum

De Web Scraping Learning Hub bevat gratis tutorials en handleidingen voor het beheersen van webscraping met Python en andere talen.

Ebooks

ScraperAPI heeft nuttige gratis e-boeken gepubliceerd, zoals "Web Scraping: The Basics uitgelegd", waarin de basisbeginselen van webschrapen worden onderwezen.

Webinars

Ze organiseren gratis webinars over onderwerpen als “Scraping JavaScript Websites”, “Building Data Pipelines” enz., die praktische tips bieden.

Demoprojecten

De demoprojecten bevatten volledig gecodeerde webscraping-scripts voor real-world scraping-taken waar u van kunt leren.

Blog

ScraperAPI's blog bevat tutorials en artikelen over best practices voor webscrapen. Deze gratis bronnen zijn van onschatbare waarde voor het gratis beheersen van webscraping. Zij vullen de API mooi.

Veelgestelde Vragen / FAQ

Kan ScraperAPI proxy's en browsers verwerken?

Ja, ScraperAPI beheert automatisch op de achtergrond een gedistribueerd netwerk van proxy's en browsers. U hoeft zich helemaal geen zorgen te maken over proxy's.

Kan ik gegevens achter logins schrapen?

Ja, ScraperAPI ondersteunt het verzamelen van gegevens achter logins door cookies door te geven in het API-verzoek om sessies te onderhouden.

Integreert ScraperAPI met Python?

Ja, ScraperAPI biedt een Python-bibliotheek die integratie naadloos maakt. Bibliotheken voor Node.js, Ruby, PHP, etc. zijn ook beschikbaar.

Kan ik JavaScript-websites schrapen?

Absoluut, de headless browsers van ScraperAPI geven JavaScript weer voordat ze worden geschraapt, dus JS-sites zijn geen probleem.

De ScraperAPI-recensie afronden

Nadat ik ScraperAPI uitgebreid heb gebruikt in mijn verschillende projecten, kan ik vol vertrouwen instaan voor de kwaliteit en betrouwbaarheid ervan.

Voor mijn webscraping-behoeften vinkt ScraperAPI alle juiste vakjes aan. Ik heb concurrenten zoals Apify, Octoparse, ParseHub, etc. geprobeerd, maar vind ScraperAPI de beste qua functies, gemak en prijzen.

Ik raad ScraperAPI ten zeerste aan aan elk individu, team of bedrijf dat webgegevens op grote schaal moet extraheren. Het bespaart u zeker urenlang complex codeer- en instelwerk, zodat u zich kunt concentreren op het afleiden van inzichten uit de gegevens.

Quick Links:

- HilltopAds Review 2023: alle GEO's hoge CPM-netwerken zijn er

- Zeydoo Review 2023: Maximaliseer uw inkomsten met Zeydoo

- 8 Beste Antidetect-browsers voor Affiliates 2023 (gratis en betaald)

- Minea Review 2023: een geavanceerd hulpmiddel voor productonderzoek (Minea-coupons en promotiecodes)

Affiliate openbaring: Dit bericht kan enkele gelieerde links bevatten, wat betekent dat we een commissie kunnen ontvangen als je iets koopt dat we aanbevelen zonder extra kosten voor jou (geen enkele!)

![Writesonic Review 2024: de ultieme tool voor copywriting [voor- en nadelen] 11 Writesonic Review 2024: de ultieme tool voor copywriting [voor- en nadelen]](https://bloggingeclipse.com/wp-content/uploads/2022/03/Writesonic-Review-1024x512.webp)