Я использую различные инструменты для парсинга веб-страниц несколько лет теперь собираю данные для своих аналитических отчетов.

Недавно я наткнулся на ScraperAPI и был полностью впечатлен его возможностями.

Теперь в этом подробном обзоре ScraperAPI я поделюсь своим личным опытом использования ScraperAPI, объясню все его ключевые функции, шаг за шагом руководство использовать его, а также предоставить информацию о некоторых свободные ресурсы предлагаемый ScraperAPI.

Зачем вам нужен инструмент для парсинга веб-страниц?

Если вы выполняете работу, где вам регулярно необходимо собирать данные с разных веб-сайтов для включения в создаваемые вами аналитические отчеты.

Ручное извлечение данным с веб-сайтов может быть утомительным и отнимающим много времени. Инструменты парсинга веб-страниц автоматизируют этот процесс, программно извлекая данные с веб-страниц.

Если вы искали мощный инструмент для парсинга веб-страниц, который мог бы помочь вам эффективно собирать все виды данных из электронная коммерция сайты, сайты обзоров, объявления, результаты поисковой системы страницы и многое другое. Ключевыми вещами, которые вам нужны были:

Протестировав множество инструментов, я наконец нашел ScraperAPI, который соответствует всем моим требованиям и может принести пользу и вам. Теперь давайте посмотрим на подробный обзор ScraperAPI.

Что такое ScraperAPI?

СкребокAPI — это API веб-скрапинга, который позволяет извлекать данные практически с любого веб-сайта с помощью вызовов REST API.

Он справляется со всеми сложностями парсинга веб-страниц, такими как прокси, браузеры, CAPTCHA и т. д., чтобы вы могли сосредоточиться только на получении необходимых вам данных.

ScraperAPI был основан в 2018 и быстро стал одним из самых популярных и надежных соскоб сервисов.

Основными причинами его популярности являются простое и быстрое извлечение данных с использованием вызовов API, мощная асинхронная очистка для крупномасштабного сбора данных, встроенные прокси и решение CAPTCHA для беспрепятственного сбора данных, а также обширная документация и поддержка интеграции.

По моему опыту, ScraperAPI решает две самые большие проблемы парсинга веб-страниц — скорость и масштаб. Это позволило мне извлекать данные с тысяч веб-страниц в час без каких-либо сбоев при очистке.

Ключевые предложения ScraperAPI

ScraperAPI предлагает различные решения и функции для легкого парсинга веб-страниц. Вот некоторые из его наиболее полезных возможностей:

1. Служба асинхронного парсера

Служба Async Scraper от ScraperAPI позволяет одновременно выполнять крупномасштабные задания по парсингу веб-страниц с вероятностью успеха 99.99%.

Он использует расширенные механизмы для обхода систем защиты от очистки и возврата запрошенных данных через простой вызов API.

Асинхронный парсер отправляет задания через конечную точку async.scraperapi.com. Затем он использует обучение с помощью машины и статистический анализ для определения оптимального сочетания IP-адресов, заголовков, решения CAPTCHA и других конфигураций для облегчения очистки даже самых сложных веб-сайтов.

Пользователи могут парсить миллионы URL-адресов, не управляя таймаутами и повторными попытками самостоятельно — асинхронный парсер обрабатывает все это автоматически. Результаты отправляются обратно через статус URL или вебхук, как только парсинг будет завершен.

Основные преимущества включают встроенный Рендеринг JavaScript, геотаргетинг, автоматическая ротация IP-адресов, анализ структурированных данных и решение CAPTCHA.

Асинхронный парсер сочетает в себе всю мощь традиционного API ScraperAPI с дополнительной возможностью одновременного парсинга неограниченного количества страниц.

Асинхронный парсер идеально подходит для крупномасштабных проектов парсинга, которым требуются данные с миллионов URL-адресов. Его автоматизированные механизмы и надежность делают его идеальным для тех, кому нужно парсить сложные веб-сайты в больших масштабах.

2. Рендеринг JavaScript

Многие веб-сайты сегодня в значительной степени полагаются на JavaScript для отображения содержание. Обычные парсеры не могут извлекать данные из контента, сгенерированного JavaScript.

Впечатляет то, что безголовые браузеры ScraperAPI визуализируют JavaScript «на лету» перед парсингом. Это позволяет беспрепятственно собирать данные даже с самых сложных сайтов JavaScript.

3. Решение CAPTCHA

CAPTCHA может блокировать доступ парсеров к данным. ScraperAPI имеет встроенный OCR возможности автоматического решения CAPTCHA в режиме реального времени. Это позволяет легко обходить CAPTCHA без какой-либо ручной работы.

4. Структурированные данные

ScraperAPI может извлекать структурированные данные, такие как информация о продукте, данные обзоров, результаты поиска и т. д., и выводить их в JSON формат.

Эти структурированные данные легко использовать для приложений анализа и машинного обучения без необходимости очистки данных.

Например, я использовал ScraperAPI для извлечения 5000 Amazon. списки продуктов с полной структурированной информацией, такой как название, рейтинг, цена и т. д., в одном вызове API.

5. Парсинг Google и Amazon

ScraperAPI предоставляет специализированные решения для очистки данных из Google и Amazon. Он позволяет пользователям извлекать структурированные данные из Google Shopping, Google Search, API рекламы продуктов Amazon и т. д.

Для меня было неоценимо получить списки продуктов, результаты поиска, обзоры, данные о ценах и т. д. от Amazon и Google.

Что касается Google, он может собирать данные из многочисленных поисковых запросов и преобразовывать их в структурированные данные JSON, которые можно использовать для различных целей, таких как исследование рынка, Инструменты SEOи мониторинг конкурентов.

Для Amazon ScraperAPI упрощает сбор крупномасштабных данных, минуя технологию защиты от очистки Amazon. Он предоставляет руководство по очистке данных Amazon с помощью Python Scrapy и ScraperAPI, а также имеет функцию автоматического анализа, которая позволяет собирать данные JSON из Amazon с использованием стандартной конечной точки API, возвращая всю соответствующую информацию в структурированном формате.

6. Конвейер данных

Функция конвейера данных ScraperAPI позволяет автоматизировать крупномасштабные проекты очистки данных без написания единой строки кода.

Эта низкий код Решение снижает необходимость сложного кодирования и обслуживания вашего собственного скрепера, тем самым сокращая инженерные ресурсы и затраты.

С помощью Data Pipeline вы можете запланировать автоматический сбор данных по 10,000 XNUMX URL-адресам, что делает его идеальным для управления большими проектами по извлечению данных.

Он предоставляет вам полный контроль над тем, как и где получить ваши данные, позволяя отправлять данные непосредственно в любую папку вашего приложения, место хранения документов или e-mail.

В дополнение к этому функция конвейера данных также предлагает интеграцию веб-перехватчиков, устраняя необходимость ручной загрузки или копирования.

Эксклюзивный купон ScraperAPI 2024 г.

СКИДКА 10% на купон ScraperAPI

эксклюзив

Используйте наш эксклюзивный код купона «affnico10» и получите фиксированную скидку 10 % на любой план подписки ScraperAPI.

Сохранить 10%

Примечательно, что вы можете сэкономить 20%, если воспользуетесь нашим кодом купона «affnico10» с ежегодным выставлением счетов, т.е.; 10% при использовании нашего кода скидки + 10% при ежегодном выставлении счетов ScraperAPI.

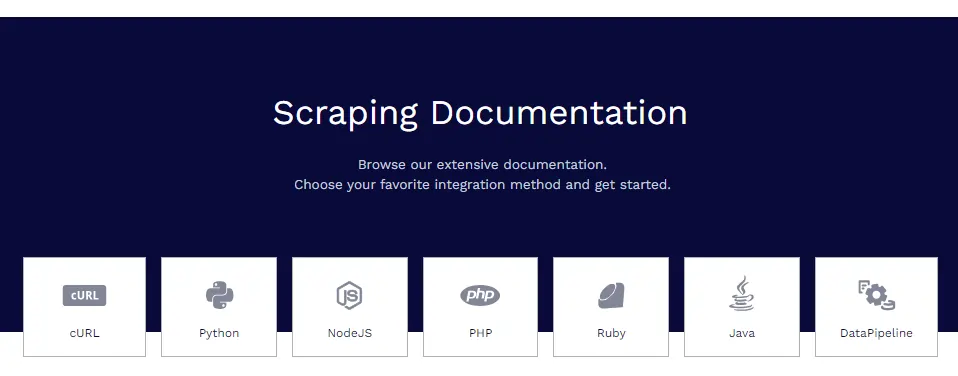

Документация ScraperAPI

ScraperAPI имеет обширную и хорошо организованную документацию, которая подробно описывает все его функции с примерами кода на Python, Node.js, Ruby, PHP и других языках.

Некоторые из полезных ресурсов документации:

- Начало работы – установка, аутентификация и первый вызов API.

- Извлечение структурированных данных. Извлечение структурированных данных из электронной коммерции, объявлений, каталогов и т. д.

- Сервисы Google – руководства по парсингу Google Shopping, Google Maps, Google Flights и многого другого.

- Конвейеры данных — настройка автоматизированных конвейеров парсинга.

- Формат ответа — подробная информация о структуре вывода JSON.

Документы содержат все, что вам нужно, чтобы овладеть навыками очистки данных с помощью ScraperAPI.

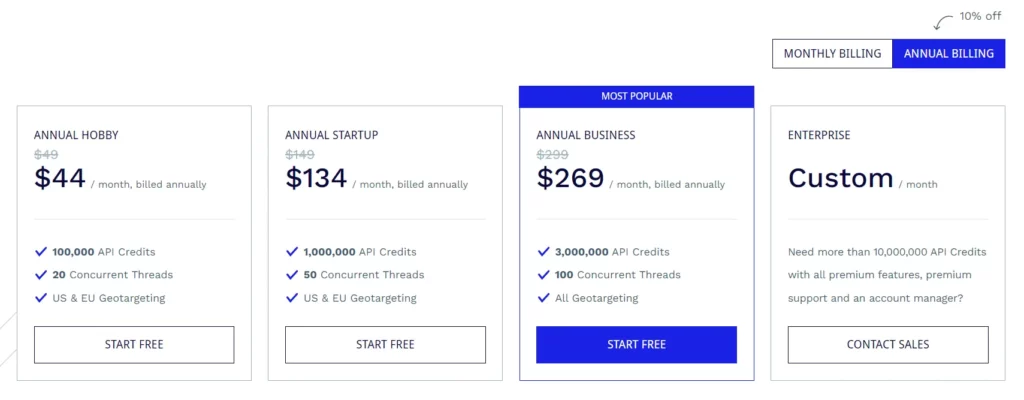

Планы подписки ScraperAPI

План для хобби (49 доллара в месяц)

- 100,000 XNUMX кредитов API

- 20 одновременных потоков

- Геотаргетинг США и ЕС

Стартовый план (149 долларов в месяц)

- 1,000,000 XNUMX кредитов API

- 50 одновременных потоков

- Геотаргетинг США и ЕС

Бизнес-план (299 долларов в месяц)

- 3,000,000 XNUMX кредитов API

- 100 одновременных потоков

- Все варианты геотаргетинга

Корпоративный план (индивидуальное ценообразование)

- Индивидуальный план на более чем 10,000,000 XNUMX XNUMX кредитов API.

- Премиум-функции, премиум-поддержка и специальный менеджер по работе с клиентами.

Все планы включают такие функции, как рендеринг JavaScript, прокси-серверы Premium, автоматический анализ JSON, интеллектуальную ротацию прокси, поддержку пользовательских заголовков, неограниченную пропускную способность, автоматические повторы, пользовательские агенты для настольных и мобильных устройств, гарантию безотказной работы 99.9%, поддержку пользовательских сеансов, CAPTCHA и защиту от ботов. обнаружение и профессиональная поддержка.

ScraperAPI также предоставляет бесплатную пробную версию, которая включает 5,000 кредитов API на 7 дней.

Некоторые бесплатные ресурсы от ScraperAPI

В дополнение к API ScraperAPI также предлагает множество бесплатных ресурсов для изучения веб-скрапинга:

Центр обучения веб-скрапингу

Ассоциация Центр обучения веб-скрапингу содержит бесплатные учебные пособия и руководства по освоению веб-скрапинга с помощью Python и других языков.

Электронные книги

ScraperAPI опубликовал полезные бесплатные электронные книги, такие как «Парсинг веб-страниц: объяснение основ», в которых обучаются основам парсинга веб-страниц.

Вебинары

Они проводят бесплатные вебинары по таким темам, как «Парсинг веб-сайтов JavaScript», «Создание конвейеров данных» и т. д., на которых даются практические советы.

Демо-проекты

Демонстрационные проекты включают полностью закодированные сценарии парсинга веб-страниц для реальных задач парсинга, на которых вы можете поучиться.

Блог

ScraperAPI Блог содержит учебные пособия и статьи по передовым методам парсинга веб-страниц. Эти бесплатные ресурсы неоценимы для бесплатного освоения веб-скрапинга. Они дополняют API мило.

Часто задаваемые вопросы

Работает ли ScraperAPI с прокси-серверами и браузерами?

Да, ScraperAPI автоматически управляет распределенной сетью прокси и браузеров в фоновом режиме. Вам вообще не нужно беспокоиться о прокси.

Могу ли я очистить данные при входе в систему?

Да, ScraperAPI поддерживает очистку данных при входе в систему, передавая файлы cookie в запросе API для поддержания сеансов.

Интегрируется ли ScraperAPI с Python?

Да, ScraperAPI предоставляет библиотеку Python, которая упрощает интеграцию. Также доступны библиотеки для Node.js, Ruby, PHP и т. д.

Могу ли я парсить веб-сайты JavaScript?

Определенно, безголовые браузеры ScraperAPI отображают JavaScript перед парсингом, поэтому сайты JS не являются проблемой.

Завершение обзора ScraperAPI

После того, как я активно использовал ScraperAPI в своих различных проектах, я могу с уверенностью ручаться за его качество и надежность.

Для моих нужд в парсинге веб-страниц ScraperAPI отвечает всем нужным требованиям. Я пробовал конкурентов, таких как Apify, Octoparse, ParseHub и т. д., но считаю ScraperAPI лучшим с точки зрения функций, удобства и цены.

Я настоятельно рекомендую ScraperAPI любому человеку, команде или компании, которым необходимо извлекать веб-данные в большом масштабе. Это, несомненно, сэкономит вам часы сложной работы по кодированию и настройке, чтобы вы могли сосредоточиться на получении ценной информации из данных.

Быстрые ссылки:

- Обзор HilltopAds 2023: сеть с высокой ценой за тысячу показов во всех регионах мира уже здесь

- Обзор Zeydoo 2023: увеличьте свой доход с Zeydoo

- 8 лучших браузеров Antidetect для партнеров 2023 (бесплатно и платно)

- Обзор Minea 2023: расширенный инструмент исследования продукта (купоны и промокоды Minea)

Affiliate Разглашение: Этот пост может содержать некоторые партнерские ссылки, что означает, что мы можем получать комиссию, если вы покупаете что-то, что мы рекомендуем, без каких-либо дополнительных затрат для вас (ни за что!)