ฉันใช้เครื่องมือขูดเว็บต่างๆมาเป็นเวลา ไม่กี่ปี ตอนนี้เพื่อรวบรวมข้อมูลสำหรับรายงานการวิเคราะห์ของฉัน

เมื่อเร็วๆ นี้ ฉันได้พบกับ ScraperAPI และประทับใจในความสามารถของมันเป็นอย่างมาก

ในการตรวจสอบ ScraperAPI โดยละเอียดนี้ ฉันจะแบ่งปันประสบการณ์ส่วนตัวของฉันในการใช้ ScraperAPI อธิบายคุณสมบัติหลักทั้งหมด ขั้นตอนโดยขั้นตอนคู่มือ เพื่อใช้งานและยังให้ข้อมูลบางอย่างด้วย แหล่งข้อมูลฟรี นำเสนอโดย ScraperAPI

ทำไมคุณถึงต้องใช้เครื่องมือขูดเว็บ?

หากคุณอยู่ในงานที่ต้องรวบรวมข้อมูลจากเว็บไซต์ต่างๆ เป็นประจำเพื่อรวมไว้ในรายงานการวิเคราะห์ที่คุณสร้าง

การสกัดด้วยตนเอง ข้อมูล จากเว็บไซต์อาจจะน่าเบื่อและใช้เวลานาน เครื่องมือขูดเว็บทำให้กระบวนการนี้เป็นอัตโนมัติโดยแยกข้อมูลจากหน้าเว็บโดยทางโปรแกรม

หากคุณกำลังมองหาเครื่องมือขูดเว็บที่มีประสิทธิภาพซึ่งสามารถช่วยให้คุณรวบรวมข้อมูลทุกประเภทได้อย่างมีประสิทธิภาพ E-commerce เว็บไซต์, เว็บไซต์บทวิจารณ์, คลาสสิฟายด์, ผลการค้นหา หน้า และอื่นๆ สิ่งสำคัญที่คุณต้องการคือ:

หลังจากทดสอบเครื่องมือมากมาย ในที่สุดฉันก็พบ ScraperAPI ที่ตรงตามความต้องการของฉันทั้งหมดและสามารถเป็นประโยชน์ต่อคุณได้เช่นกัน ตอนนี้เรามาดูการตรวจสอบโดยละเอียดของ ScraperAPI กัน

ScraperAPI คืออะไร

ScraperAPI เป็น API การขูดเว็บที่ช่วยให้คุณสามารถดึงข้อมูลจากเกือบทุกเว็บไซต์โดยใช้การเรียก REST API

มันจัดการความซับซ้อนทั้งหมดของการขูดเว็บเช่น ผู้รับมอบฉันทะ, เบราว์เซอร์, CAPTCHA ฯลฯ เบื้องหลังเพื่อให้คุณมุ่งความสนใจไปที่การรับข้อมูลที่ต้องการเท่านั้น

ScraperAPI ก่อตั้งขึ้นเมื่อปีพ 2018 และได้กลายเป็นหนึ่งในความนิยมและความน่าเชื่อถืออย่างรวดเร็วที่สุด การขูดเว็บ บริการ

เหตุผลหลักที่ทำให้ได้รับความนิยมคือการดึงข้อมูลที่ง่ายและรวดเร็วโดยใช้การเรียก API, การขูดแบบอะซิงก์ที่มีประสิทธิภาพสำหรับการรวบรวมข้อมูลขนาดใหญ่, พร็อกซีในตัวและการแก้ไข CAPTCHA สำหรับการคัดลอกที่ราบรื่น และเอกสารประกอบที่กว้างขวางและการสนับสนุนการรวมระบบ

จากประสบการณ์ของฉัน ScraperAPI แก้ปัญหาที่ใหญ่ที่สุดสองประการของการขูดเว็บ – ความเร็วและขนาด มันช่วยให้ฉันสามารถดึงข้อมูลจากหน้าเว็บหลายพันหน้าต่อชั่วโมงโดยไม่มีข้อผิดพลาดในการคัดลอก

ข้อเสนอที่สำคัญของ ScraperAPI

ScraperAPI นำเสนอโซลูชั่นและคุณสมบัติที่หลากหลายสำหรับการขูดเว็บที่ง่ายดาย นี่คือความสามารถที่มีประโยชน์ที่สุดบางส่วน:

1. บริการ Async Scraper

Async Scraper Service ของ ScraperAPI ช่วยให้งานขูดเว็บขนาดใหญ่สามารถดำเนินการไปพร้อมๆ กันได้ที่อัตราความสำเร็จ 99.99%

ใช้กลไกขั้นสูงเพื่อหลีกเลี่ยงระบบป้องกันการขูดและส่งคืนข้อมูลที่ร้องขอผ่านการเรียก API แบบธรรมดา

ตัวขูด async ส่งงานผ่านตำแหน่งข้อมูล async.scraperapi.com จากนั้นมันก็ยกระดับ เรียนรู้เครื่อง และการวิเคราะห์ทางสถิติเพื่อกำหนดการผสมผสานที่เหมาะสมที่สุดของ IP, ส่วนหัว, การแก้ไข CAPTCHA และการกำหนดค่าอื่น ๆ เพื่ออำนวยความสะดวกในการคัดลอกเว็บไซต์ที่ยากที่สุด

ผู้ใช้สามารถดึง URL นับล้านโดยไม่ต้องจัดการการหมดเวลาหรือลองใหม่ด้วยตนเอง - ตัวขูด async จะจัดการทั้งหมดโดยอัตโนมัติ ผลลัพธ์จะถูกส่งกลับผ่านสถานะ URL หรือ webhook ทันทีที่การขูดเสร็จสิ้น

ประโยชน์ที่สำคัญ ได้แก่ บิวท์อิน การแสดงผลจาวาสคริปต์, การกำหนดเป้าหมายทางภูมิศาสตร์, การหมุนเวียน IP อัตโนมัติ, การแยกวิเคราะห์ข้อมูลที่มีโครงสร้าง และการแก้ไข CAPTCHA

ตัวขูดแบบอะซิงก์นำพลังทั้งหมดของ API ดั้งเดิมของ ScraperAPI มาพร้อมกับความสามารถเพิ่มเติมในการคัดลอกหน้าแบบไม่จำกัดพร้อมกัน

เครื่องขูดแบบอะซิงก์เหมาะอย่างยิ่งสำหรับโปรเจ็กต์การคัดลอกขนาดใหญ่ที่ต้องการข้อมูลจาก URL นับล้าน กลไกอัตโนมัติและความน่าเชื่อถือทำให้มันสมบูรณ์แบบสำหรับผู้ที่ต้องการขูดเว็บไซต์ที่ยากลำบากในวงกว้าง

2. การแสดงผลจาวาสคริปต์

เว็บไซต์จำนวนมากในปัจจุบันอาศัย JavaScript เป็นอย่างมากในการแสดงผล เนื้อหา. สแครปเปอร์ปกติไม่สามารถแยกข้อมูลจากเนื้อหาที่สร้างโดย JavaScript

สิ่งที่น่าประทับใจคือเบราว์เซอร์ที่ไม่มีหัวของ ScraperAPI เรนเดอร์ JavaScript ได้ทันทีก่อนที่จะทำการคัดลอก ช่วยให้สามารถรวบรวมข้อมูลได้อย่างราบรื่นจากไซต์ JavaScript ที่ซับซ้อนที่สุด

3. การแก้แคปช่า

CAPTCHA สามารถบล็อกแครปเปอร์ไม่ให้เข้าถึงข้อมูลได้ ScraperAPI มีอยู่ภายใน OCR ความสามารถในการแก้ CAPTCHA โดยอัตโนมัติแบบเรียลไทม์ วิธีนี้สามารถข้าม CAPTCHA ได้อย่างง่ายดายโดยไม่ต้องทำงานด้วยตนเอง

4. ข้อมูลที่มีโครงสร้าง

ScraperAPI สามารถดึงข้อมูลที่มีโครงสร้าง เช่น ข้อมูลผลิตภัณฑ์ ข้อมูลรีวิว ผลการค้นหา ฯลฯ และส่งออกข้อมูลออกมาได้ JSON จัดรูปแบบ

ข้อมูลที่มีโครงสร้างนี้พร้อมใช้สำหรับการวิเคราะห์และแอปพลิเคชันแมชชีนเลิร์นนิงโดยไม่จำเป็นต้องล้างข้อมูล

ตัวอย่างเช่น ฉันใช้ ScraperAPI เพื่อแยก Amazon จำนวน 5000 รายการ รายการสินค้า พร้อมข้อมูลที่มีโครงสร้างครบถ้วน เช่น ชื่อ คะแนน ราคา ฯลฯ ในการเรียก API ครั้งเดียว

5. Google และ Amazon Scraping

ScraperAPI นำเสนอโซลูชันเฉพาะสำหรับการดึงข้อมูลจาก Google และ Amazon ช่วยให้ผู้ใช้สามารถดึงข้อมูลที่มีโครงสร้างจาก Google Shopping, Google Search, Amazon Product Advertising API และอื่นๆ อีกมากมาย

นี่เป็นสิ่งล้ำค่าสำหรับฉันในการรับรายการผลิตภัณฑ์ ผลการค้นหา บทวิจารณ์ ข้อมูลการกำหนดราคา ฯลฯ จาก Amazon และ Google

สำหรับ Google สามารถรวบรวมข้อมูลจากคำค้นหาจำนวนมากและแปลงเป็นข้อมูล JSON ที่มีโครงสร้าง ซึ่งสามารถใช้เพื่อวัตถุประสงค์ต่างๆ เช่น การวิจัยตลาด เครื่องมือ SEOและการติดตามคู่แข่ง

สำหรับ Amazon นั้น ScraperAPI ทำให้การขูดข้อมูลขนาดใหญ่ง่ายขึ้น โดยข้ามเทคโนโลยีป้องกันการขูดของ Amazon โดยให้คำแนะนำในการคัดลอกข้อมูล Amazon โดยใช้ Python Scrapy และ ScraperAPI และมีฟังก์ชันการแยกวิเคราะห์อัตโนมัติที่อนุญาตให้รวบรวมข้อมูล JSON จาก Amazon โดยใช้ตำแหน่งข้อมูล API มาตรฐาน โดยส่งคืนข้อมูลที่เกี่ยวข้องทั้งหมดในรูปแบบที่มีโครงสร้าง

6. ไปป์ไลน์ข้อมูล

คุณสมบัติ Data Pipeline ของ ScraperAPI ช่วยให้คุณสามารถดำเนินการโครงการขูดข้อมูลขนาดใหญ่ได้โดยอัตโนมัติโดยไม่ต้องเขียนโค้ดแม้แต่บรรทัดเดียว

รหัสต่ำ โซลูชันช่วยลดความจำเป็นในการเขียนโค้ดที่ซับซ้อนและการบำรุงรักษาเครื่องขูดของคุณเอง ซึ่งช่วยลดทรัพยากรและต้นทุนด้านวิศวกรรม

ด้วย Data Pipeline คุณสามารถกำหนดเวลาการรวบรวมข้อมูลอัตโนมัติได้สูงสุด 10,000 URL ทำให้เหมาะสำหรับการจัดการโปรเจ็กต์การแยกข้อมูลขนาดใหญ่

ช่วยให้คุณสามารถควบคุมวิธีและสถานที่ที่จะรับข้อมูลของคุณได้อย่างสมบูรณ์ ทำให้คุณสามารถส่งข้อมูลโดยตรงไปยังโฟลเดอร์ใดๆ ในแอปพลิเคชัน พื้นที่จัดเก็บเอกสาร หรือ อีเมล.

นอกจากนี้ คุณลักษณะ Data Pipeline ยังนำเสนอการผสานรวมเว็บฮุค ซึ่งช่วยลดความจำเป็นในการดาวน์โหลดด้วยตนเองหรือคัดลอกและวาง

คูปอง ScraperAPI สุดพิเศษปี 2024

ส่วนลด 10% จากคูปอง ScraperAPI

พิเศษ

ใช้รหัสคูปองพิเศษของเรา”อัฟนิโก10” และรับส่วนลด 10% คงที่สำหรับแผนการสมัครสมาชิก ScraperAPI ใดๆ

บันทึก 10%

คุณสามารถประหยัดได้ 20% หากคุณใช้รหัสคูปองของเรา “อัฟนิโก10” โดยมีการเรียกเก็บเงินรายปี เช่น 10% ด้วยรหัสส่วนลดของเรา + 10% พร้อมการเรียกเก็บเงินรายปีของ ScraperAPI

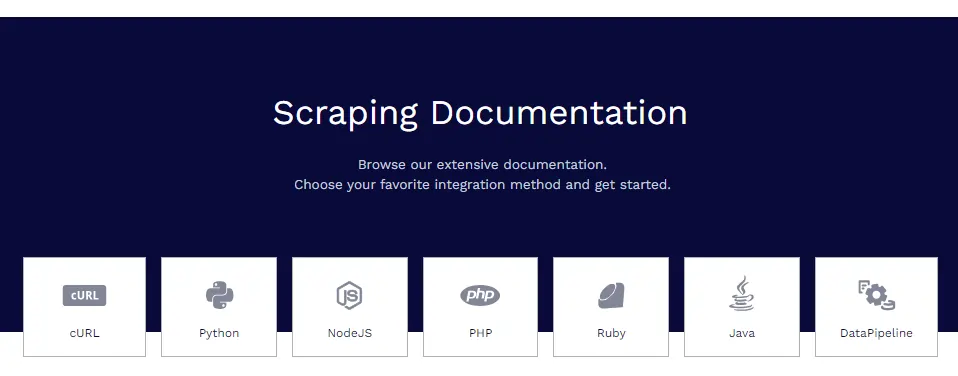

เอกสาร ScraperAPI

ScraperAPI มีเอกสารที่ครอบคลุมและมีการจัดระเบียบอย่างดี ซึ่งครอบคลุมคุณสมบัติทั้งหมดในเชิงลึกพร้อมตัวอย่างโค้ดใน Python, Node.js, Ruby, PHP และอื่นๆ

แหล่งข้อมูลเอกสารที่เป็นประโยชน์บางส่วนได้แก่:

- เริ่มต้นใช้งาน – การติดตั้ง การรับรองความถูกต้อง และการเรียก API ครั้งแรก

- การดึงข้อมูลที่มีโครงสร้าง – การคัดลอกข้อมูลที่มีโครงสร้างจากอีคอมเมิร์ซ คลาสสิฟายด์ ไดเร็กทอรี ฯลฯ

- บริการของ Google - คำแนะนำสำหรับการคัดลอก Google Shopping, Google Maps, Google Flights และอีกมากมาย

- ไปป์ไลน์ข้อมูล – การตั้งค่าไปป์ไลน์การขูดแบบอัตโนมัติ

- รูปแบบการตอบสนอง – รายละเอียดเกี่ยวกับโครงสร้างเอาต์พุต JSON

เอกสารประกอบด้วยทุกสิ่งที่คุณต้องการเพื่อให้มีความเชี่ยวชาญในการดึงข้อมูลด้วย ScraperAPI

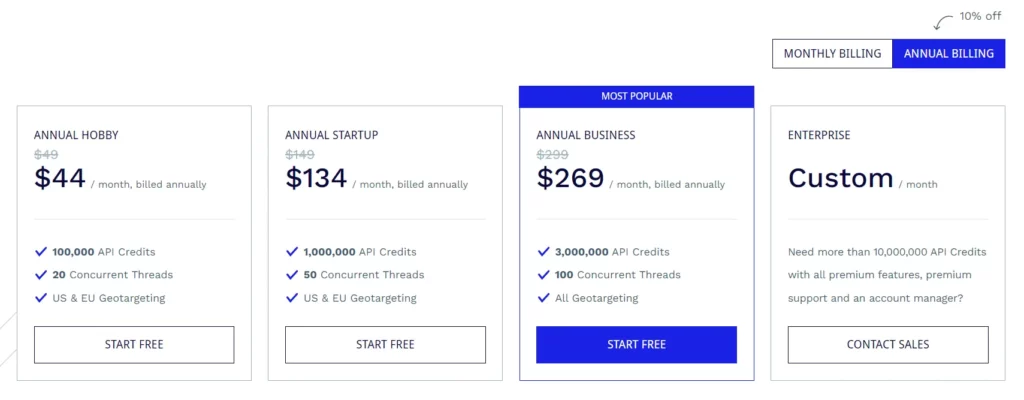

แผนการสมัครสมาชิก ScraperAPI

แผนงานอดิเรก ($49/เดือน)

- เครดิต API 100,000 หน่วย

- 20 เธรดที่เกิดขึ้นพร้อมกัน

- การกำหนดเป้าหมายตามภูมิศาสตร์ของสหรัฐอเมริกาและสหภาพยุโรป

แผนเริ่มต้น ($149/เดือน)

- เครดิต API 1,000,000 หน่วย

- 50 เธรดที่เกิดขึ้นพร้อมกัน

- การกำหนดเป้าหมายตามภูมิศาสตร์ของสหรัฐอเมริกาและสหภาพยุโรป

แผนธุรกิจ ($ 299/เดือน)

- เครดิต API 3,000,000 หน่วย

- 100 เธรดที่เกิดขึ้นพร้อมกัน

- ตัวเลือกการกำหนดเป้าหมายตามภูมิศาสตร์ทั้งหมด

แผนองค์กร (กำหนดราคาเอง)

- แผนที่กำหนดเองสำหรับเครดิต API มากกว่า 10,000,000 หน่วย

- คุณสมบัติระดับพรีเมียม การสนับสนุนระดับพรีเมียม และผู้จัดการบัญชีเฉพาะ

แผนทั้งหมดมาพร้อมกับฟีเจอร์ต่างๆ เช่น การเรนเดอร์ JavaScript, พร็อกซีพรีเมียม, การแยกวิเคราะห์อัตโนมัติ JSON, การหมุนเวียนพร็อกซีอัจฉริยะ, การสนับสนุนส่วนหัวที่กำหนดเอง, แบนด์วิดธ์ไม่จำกัด, การลองใหม่อัตโนมัติ, ตัวแทนผู้ใช้เดสก์ท็อปและมือถือ, รับประกันความพร้อมใช้งาน 99.9%, การสนับสนุนเซสชันแบบกำหนดเอง, CAPTCHA และแอนตี้บอท การตรวจจับและการสนับสนุนอย่างมืออาชีพ

ScraperAPI ยังให้ทดลองใช้ฟรีซึ่งรวมถึงเครดิต API 5,000 เป็นเวลา 7 วัน

แหล่งข้อมูลฟรีบางส่วนจาก ScraperAPI

นอกจาก API แล้ว ScraperAPI ยังมีแหล่งข้อมูลฟรีมากมายสำหรับการเรียนรู้ web scraping:

ศูนย์กลางการเรียนรู้การขูดเว็บ

พื้นที่ Web Scraping Learning Hub มีบทช่วยสอนและคำแนะนำฟรีสำหรับการเรียนรู้ web scraping ด้วย Python และภาษาอื่นๆ

ebooks

ScraperAPI ได้เผยแพร่ eBook ฟรีที่เป็นประโยชน์ เช่น “Web Scraping: The Basics Explained” ที่สอนพื้นฐานการขูดเว็บ

webinars

พวกเขาโฮสต์การสัมมนาผ่านเว็บฟรีในหัวข้อต่างๆ เช่น “การคัดลอกเว็บไซต์ JavaScript” “การสร้างไปป์ไลน์ข้อมูล” ฯลฯ ซึ่งให้คำแนะนำที่นำไปปฏิบัติได้

โครงการสาธิต

โครงการสาธิตประกอบด้วยสคริปต์การขูดเว็บที่เข้ารหัสอย่างสมบูรณ์สำหรับงานการขูดในโลกแห่งความเป็นจริงที่คุณสามารถเรียนรู้ได้

บล็อก

ScraperAPI บล็อก มีบทช่วยสอนและบทความเกี่ยวกับแนวทางปฏิบัติที่ดีที่สุดในการขูดเว็บ แหล่งข้อมูลฟรีเหล่านี้มีค่ามากสำหรับการเรียนรู้การขูดเว็บโดยไม่มีค่าใช้จ่าย พวกเขาเสริมการ API อย่างดี

คำถามที่พบบ่อย

ScraperAPI จัดการพรอกซีและเบราว์เซอร์หรือไม่

ใช่ ScraperAPI จัดการเครือข่ายพร็อกซีและเบราว์เซอร์แบบกระจายโดยอัตโนมัติในเบื้องหลัง คุณไม่จำเป็นต้องกังวลเกี่ยวกับผู้รับมอบฉันทะเลย

ฉันสามารถขูดข้อมูลหลังการเข้าสู่ระบบได้หรือไม่?

ใช่ ScraperAPI รองรับการคัดลอกข้อมูลหลังการเข้าสู่ระบบโดยการส่งคุกกี้ในคำขอ API เพื่อรักษาเซสชัน

ScraperAPI ทำงานร่วมกับ Python หรือไม่

ใช่ ScraperAPI มีไลบรารี Python ที่ทำให้การบูรณาการเป็นไปอย่างราบรื่น ไลบรารีสำหรับ Node.js, Ruby, PHP และอื่นๆ ก็มีให้บริการเช่นกัน

ฉันสามารถขูดเว็บไซต์ JavaScript ได้หรือไม่

แน่นอนว่าเบราว์เซอร์ที่ไม่มีส่วนหัวของ ScraperAPI จะแสดงผล JavaScript ก่อนที่จะทำการคัดลอก ดังนั้นไซต์ JS จะไม่เป็นปัญหา

สรุปการตรวจสอบ ScraperAPI

หลังจากใช้ ScraperAPI อย่างกว้างขวางกับโปรเจ็กต์ต่างๆ ของฉัน ฉันสามารถรับรองคุณภาพและความน่าเชื่อถือได้อย่างมั่นใจ

สำหรับความต้องการในการขูดเว็บของฉัน ScraperAPI จะทำเครื่องหมายในช่องที่ถูกต้องทั้งหมด ฉันได้ลองใช้คู่แข่งเช่น Apify, Octoparse, ParseHub ฯลฯ แต่พบว่า ScraperAPI ดีที่สุดในแง่ของฟีเจอร์ ความสะดวก และราคา

ฉันขอแนะนำ ScraperAPI เป็นอย่างยิ่งให้กับบุคคล ทีม หรือบริษัทที่ต้องการดึงข้อมูลเว็บในวงกว้าง จะช่วยคุณประหยัดเวลาในการเขียนโค้ดและการตั้งค่าที่ซับซ้อนได้อย่างแน่นอน เพื่อให้คุณสามารถมุ่งเน้นไปที่การรับข้อมูลเชิงลึกจากข้อมูลได้

ลิงค์ด่วน:

- รีวิว HilltopAds ปี 2023: เครือข่าย CPM สูงของ GEO ทั้งหมดอยู่ที่นี่แล้ว

- รีวิว Zeydoo ปี 2023: เพิ่มรายได้สูงสุดด้วย Zeydoo

- 8 เบราว์เซอร์ Antidetect ที่ดีที่สุดสำหรับ บริษัท ในเครือ 2023 (ฟรีและจ่ายเงิน)

- Minea Review 2023: เครื่องมือวิจัยผลิตภัณฑ์ขั้นสูง (คูปอง Minea และรหัสโปรโมชั่น)

เข้าร่วม การเปิดเผย: โพสต์นี้อาจมีลิงค์พันธมิตร ซึ่งหมายความว่าเราอาจได้รับค่าคอมมิชชั่นหากคุณซื้อสิ่งที่เราแนะนำโดยไม่มีค่าใช้จ่ายเพิ่มเติมสำหรับคุณ (ไม่มีเลย!)

![Writesonic Review 2024: สุดยอดเครื่องมือการเขียนคำโฆษณา [ข้อดีข้อเสีย] 11 Writesonic Review 2024: สุดยอดเครื่องมือการเขียนคำโฆษณา [ข้อดีข้อเสีย]](https://bloggingeclipse.com/wp-content/uploads/2022/03/Writesonic-Review-1024x512.webp)