Я використовую різні інструменти для копіювання веб-сторінок для a кілька років тепер збираю дані для своїх аналітичних звітів.

Нещодавно я натрапив на ScraperAPI і був справді вражений його можливостями.

Тепер у цьому детальному огляді ScraperAPI я поділюся своїм особистим досвідом використання ScraperAPI, поясню всі його ключові функції, крок за кроком керівництво використовувати його, а також надати інформацію про деякі вільні ресурси пропонує ScraperAPI.

Навіщо вам потрібен інструмент для сканування веб-сторінок?

Якщо ви на роботі, де вам регулярно потрібно збирати дані з різних веб-сайтів для включення в аналітичні звіти, які ви створюєте.

Витяг вручну дані з веб-сайтів може бути виснажливим і трудомістким. Інструменти веб-збирання автоматизують цей процес шляхом програмного вилучення даних із веб-сторінок.

Якщо ви шукали потужний інструмент для збирання веб-сторінок, який міг би допомогти вам ефективно збирати всі типи даних e-commerce сайти, сайти оглядів, оголошення, результати пошукової системи сторінки тощо. Ключові речі, які вам потрібні були:

Після тестування багатьох інструментів я нарешті знайшов ScraperAPI, який відповідає всім моїм вимогам і може бути корисним і вам. Тепер давайте розглянемо детальний огляд ScraperAPI.

Що таке ScraperAPI?

ScraperAPI це API для веб-збирання, який дозволяє отримувати дані майже з будь-якого веб-сайту за допомогою викликів REST API.

Він справляється з усіма складнощами веб-збирання, наприклад проксі, браузери, CAPTCHA тощо, щоб ви могли зосередитися лише на отриманні необхідних даних.

ScraperAPI було засновано в 2018 і швидко став одним із найпопулярніших і надійніших веб-вискоблювання services.

Основними причинами його популярності є просте та швидке вилучення даних за допомогою викликів API, потужне асинхронне сканування для великомасштабного збору даних, вбудовані проксі та розв’язання CAPTCHA для безперебійного збирання, а також обширна документація та підтримка інтеграції.

З мого досвіду ScraperAPI вирішує дві найбільші проблеми веб-збирання – швидкість і масштаб. Це дозволило мені отримувати дані з тисяч веб-сторінок на годину без будь-яких збоїв під час сканування.

Ключові пропозиції ScraperAPI

ScraperAPI пропонує різноманітні рішення та функції для легкого веб-збирання. Ось деякі з його найкорисніших можливостей:

1. Служба асинхронного скребка

Служба Async Scraper від ScraperAPI дозволяє одночасно виконувати великомасштабні завдання веб-збирання з показником успішності 99.99%.

Він використовує розширені механізми для обходу систем захисту від сканування та повернення запитаних даних за допомогою простого виклику API.

Асинхронний скрейпер надсилає завдання через кінцеву точку async.scraperapi.com. Потім це важелі навчання за допомогою машини і статистичний аналіз для визначення оптимальної комбінації IP-адрес, заголовків, розв’язання CAPTCHA та інших конфігурацій для полегшення сканування навіть найскладніших веб-сайтів.

Користувачі можуть очищати мільйони URL-адрес, не керуючи тайм-аутами чи повторними спробами – асинхронний скребок обробляє все це автоматично. Результати надсилаються назад через статус URL або вебхук, щойно збирання буде завершено.

Основні переваги включають вбудований Відтворення JavaScript, геотаргетинг, автоматична ротація IP-адрес, аналіз структурованих даних і розв’язування CAPTCHA.

Асинхронний скребок забезпечує всю потужність традиційного API ScraperAPI з доданою можливістю сканувати необмежену кількість сторінок одночасно.

Асинхронний скрейпер ідеально підходить для великомасштабних проектів скрапінгу, які потребують даних з мільйонів URL-адрес. Його автоматизовані механізми та надійність роблять його ідеальним для тих, кому потрібно масштабувати складні веб-сайти.

2. Відтворення JavaScript

Багато веб-сайтів сьогодні значною мірою покладаються на JavaScript для візуалізації зміст. Звичайні скребки не можуть отримувати дані з вмісту, створеного JavaScript.

Вражає те, що безголові браузери ScraperAPI відтворюють JavaScript на льоту перед скрапінгом. Це дозволяє безперешкодно збирати дані навіть із найскладніших сайтів JavaScript.

3. Розгадування CAPTCHA

CAPTCHA може блокувати скребкам доступ до даних. ScraperAPI має вбудований OCR можливість автоматично розпізнавати CAPTCHA в режимі реального часу. Це дозволяє легко обходити CAPTCHA без ручної роботи.

4. Структуровані дані

ScraperAPI може отримувати структуровані дані, як-от інформацію про продукт, дані відгуків, результати пошуку тощо, і виводити JSON Формат.

Ці структуровані дані легко використовувати для аналізу та програм машинного навчання без необхідності очищення даних.

Наприклад, я використовував ScraperAPI, щоб отримати 5000 Amazon списки товарів із повною структурованою інформацією, як-от назва, рейтинг, ціна тощо, в одному виклику API.

5. Google і Amazon Scraping

ScraperAPI надає спеціалізовані рішення для збирання даних із Google і Amazon. Це дозволяє користувачам отримувати структуровані дані з Google Shopping, Google Search, Amazon Product Advertising API тощо.

Для мене було безцінним отримання списків продуктів, результатів пошуку, оглядів, даних про ціни тощо від Amazon і Google.

Для Google він може збирати дані з численних пошукових запитів і перетворювати їх у структуровані дані JSON, які можна використовувати для різних цілей, наприклад дослідження ринку, SEO інструменти, і моніторинг конкурентів.

Для Amazon ScraperAPI спрощує збирання великомасштабних даних, минаючи технологію захисту від збирання даних Amazon. Він надає посібник із збирання даних Amazon за допомогою Python Scrapy та ScraperAPI, а також має функцію автоматичного аналізу, яка дозволяє збирати дані JSON з Amazon за допомогою стандартної кінцевої точки API, повертаючи всю відповідну інформацію в структурованому форматі.

6. Конвеєр даних

Функція Data Pipeline ScraperAPI дозволяє автоматизувати масштабні проекти збирання даних без написання жодного рядка коду.

це низькокодовий рішення зменшує потребу в складному кодуванні та обслуговуванні вашого власного скребка, тим самим зменшуючи інженерні ресурси та витрати.

За допомогою Data Pipeline ви можете запланувати автоматичний збір даних до 10,000 XNUMX URL-адрес, що робить його ідеальним для керування великими проектами вилучення даних.

Він надає вам повний контроль над тим, як і де отримати ваші дані, дозволяючи надсилати дані безпосередньо в будь-яку папку у вашій програмі, простір для зберігання документів або e-mail.

На додаток до цього, функція Data Pipeline також пропонує інтеграцію webhook, усуваючи необхідність ручного завантаження або копіювання.

Ексклюзивний купон ScraperAPI 2024

ЗНИЖКА 10% на купон ScraperAPI

ексклюзивний

Використовуйте наш ексклюзивний код купона "affnico10” і отримайте фіксовану знижку 10% на будь-який план передплати ScraperAPI.

Зберегти 10%

Варто відзначити, що ви можете заощадити 20%, якщо використовуєте наш код купона "affnico10” із щорічним виставленням рахунків, тобто; 10% з нашим кодом знижки + 10% з річним виставленням рахунку ScraperAPI.

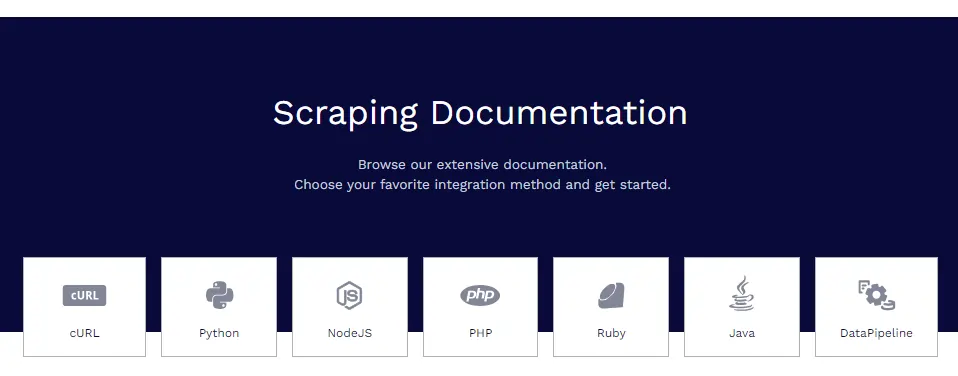

Документація ScraperAPI

ScraperAPI має обширну та добре організовану документацію, яка детально охоплює всі його функції з прикладами коду на Python, Node.js, Ruby, PHP тощо.

Деякі з корисних ресурсів документації:

- Початок роботи – встановлення, автентифікація та перший виклик API.

- Вилучення структурованих даних – збирання структурованих даних з електронної комерції, оголошень, каталогів тощо.

- Сервіси Google – посібники для копіювання Google Shopping, Google Maps, Google Flights тощо.

- Конвеєри даних – налаштування автоматизованих конвеєрів збирання даних.

- Формат відповіді – подробиці про вихідну структуру JSON.

Документи містять усе, що вам потрібно, щоб навчитися збирати дані за допомогою ScraperAPI.

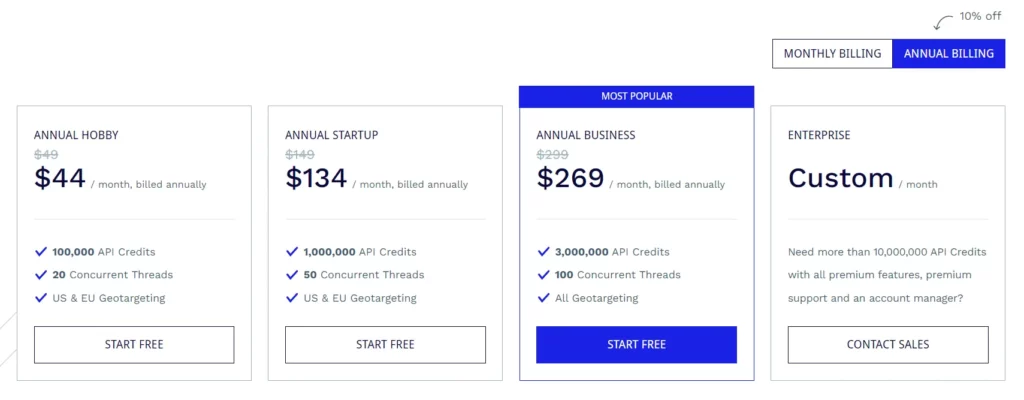

Плани передплати ScraperAPI

Хобі план ($49/місяць)

- 100,000 XNUMX кредитів API

- 20 одночасних потоків

- Геотаргетинг США та ЄС

Стартовий план ($149/місяць)

- 1,000,000 XNUMX кредитів API

- 50 одночасних потоків

- Геотаргетинг США та ЄС

Бізнес-план ($299/місяць)

- 3,000,000 XNUMX кредитів API

- 100 одночасних потоків

- Всі параметри геотаргетингу

План Enterprise (спеціальні ціни)

- Індивідуальний план для понад 10,000,000 XNUMX XNUMX кредитів API.

- Преміум-функції, преміальна підтримка та спеціальний менеджер облікового запису.

Усі плани мають такі функції, як візуалізація JavaScript, проксі-сервери преміум-класу, автоматичний аналіз JSON, інтелектуальна ротація проксі-сервера, підтримка користувацьких заголовків, необмежена пропускна здатність, автоматичні повторні спроби, агенти користувачів для настільних і мобільних пристроїв, гарантія безвідмовної роботи на 99.9%, підтримка користувацьких сеансів, CAPTCHA та антибот виявлення та професійна підтримка.

ScraperAPI також надає безкоштовну пробну версію, яка включає 5,000 кредитів API на 7 днів.

Деякі безкоштовні ресурси від ScraperAPI

Окрім API, ScraperAPI також пропонує багато безкоштовних ресурсів для вивчення веб-скрейпінгу:

Навчальний центр Web Scraping

Команда Web Scraping Learning Hub містить безкоштовні підручники та посібники для опанування веб-скрапінгу за допомогою Python та інших мов.

Електронні книги

ScraperAPI опублікував корисні безкоштовні електронні книги, такі як «Web Scraping: The Basics Explained», які навчають основам веб-скрапінгу.

Вебінари

Вони проводять безкоштовні вебінари на такі теми, як «Викопування веб-сайтів JavaScript», «Створення конвеєрів даних» тощо, які надають практичні поради.

Демо проекти

Демонстраційні проекти включають повністю закодовані веб-сценарії скрапінгу для реальних завдань скрапінгу, на яких ви можете навчитися.

Блог

ScraperAPI блозі містить навчальні посібники та статті про найкращі практики веб-збирання. Ці безкоштовні ресурси є безцінними для безкоштовного освоєння веб-збирання. Вони доповнюють API чудово.

ЧАСТІ ЗАПИТАННЯ

Чи працює ScraperAPI з проксі та браузерами?

Так, ScraperAPI автоматично керує розподіленою мережею проксі та браузерів у фоновому режимі. Вам взагалі не потрібно турбуватися про проксі.

Чи можу я очищати дані після входу?

Так, ScraperAPI підтримує збирання даних після входу шляхом передачі файлів cookie в запиті API для підтримки сеансів.

Чи інтегрується ScraperAPI з Python?

Так, ScraperAPI надає бібліотеку Python, яка робить інтеграцію легкою. Також доступні бібліотеки для Node.js, Ruby, PHP тощо.

Чи можу я очищати веб-сайти JavaScript?

Звичайно, безголові браузери ScraperAPI відтворюють JavaScript перед скрапінгом, тому сайти JS не є проблемою.

Підсумок огляду ScraperAPI

Після широкого використання ScraperAPI в моїх різних проектах я можу впевнено ручатися за його якість і надійність.

Для моїх потреб у веб-скрапінгу ScraperAPI відповідає всім вимогам. Я спробував таких конкурентів, як Apify, Octoparse, ParseHub тощо, але вважаю ScraperAPI найкращим з точки зору функцій, зручності та ціни.

Я настійно рекомендую ScraperAPI будь-якій особі, команді чи компанії, яким потрібно видобувати веб-дані в масштабі. Це, безперечно, заощадить вам години складної роботи з кодування та налаштування, щоб ви могли зосередитися на отриманні інформації з даних.

Швидкі посилання:

- Огляд HilltopAds 2023: мережа високої CPM усіх GEO тут

- Огляд Zeydoo 2023: максимізуйте свої прибутки разом із Zeydoo

- 8 найкращих антидетекторних браузерів для партнерів 2023 (безкоштовні та платні)

- Minea Review 2023: розширений інструмент дослідження продукту (купони та промо-коди Minea)

філія Розкриття: Ця публікація може містити деякі партнерські посилання, що означає, що ми можемо отримати комісію, якщо ви придбаєте те, що ми рекомендуємо, без додаткових витрат (жодних!)