J'utilise divers outils de web scraping depuis un quelques années maintenant pour collecter des données pour mes rapports d'analyse.

Récemment, je suis tombé sur ScraperAPI et j'ai été très impressionné par ses capacités.

Maintenant, dans cette revue détaillée de ScraperAPI, je vais partager mon expérience personnelle avec ScraperAPI, expliquer toutes ses fonctionnalités clés, un étape par étape pour l'utiliser, et également fournir des informations sur certains ressources gratuites proposé par ScraperAPI.

Pourquoi avez-vous besoin d’un outil de Web Scraping ?

Si vous occupez un emploi où vous devez régulièrement collecter des données sur différents sites Web pour les inclure dans les rapports d'analyse que vous créez.

Extraction manuelle données à partir de sites Web peut être fastidieux et prendre beaucoup de temps. Les outils de scraping Web automatisent ce processus en extrayant par programme les données des pages Web.

Si vous recherchiez un outil de scraping Web puissant qui pourrait vous aider à collecter efficacement toutes sortes de données à partir de e-commerce sites, sites d'avis, petites annonces, résultats du moteur de recherche pages, et plus encore. Les éléments clés dont vous aviez besoin étaient :

Après avoir testé de nombreux outils, j'ai finalement trouvé ScraperAPI qui répondait à toutes mes exigences et qui peut également vous être utile. Jetons maintenant un coup d'œil à un examen détaillé de ScraperAPI.

Qu’est-ce que ScraperAPI ?

GrattoirAPI est une API de web scraping qui vous permet d'extraire des données de presque n'importe quel site Web à l'aide d'appels d'API REST.

Il gère toutes les complexités du web scraping comme proxies, navigateurs, CAPTCHA, etc. en coulisses afin que vous puissiez vous concentrer uniquement sur l'obtention des données dont vous avez besoin.

ScraperAPI a été fondée en 2018 et est rapidement devenu l'un des plus populaires et des plus fiables grattage web prestations de service.

Les principales raisons de sa popularité sont l'extraction de données simple et rapide à l'aide d'appels API, le scraping asynchrone puissant pour la collecte de données à grande échelle, les proxys intégrés et la résolution de CAPTCHA pour un scraping transparent, ainsi qu'une documentation et une prise en charge étendues de l'intégration.

D'après mon expérience, ScraperAPI résout les deux plus gros problèmes du web scraping : la vitesse et l'évolutivité. Cela m'a permis d'extraire des données de milliers de pages Web par heure sans aucun échec de scraping.

Offres clés de ScraperAPI

ScraperAPI propose diverses solutions et fonctionnalités pour un Web Scraping sans effort. Voici quelques-unes de ses fonctionnalités les plus utiles :

1. Service de grattage asynchrone

Le service Async Scraper de ScraperAPI permet d'effectuer simultanément des tâches de scraping Web à grande échelle avec un taux de réussite de 99.99 %.

Il utilise des mécanismes avancés pour contourner les systèmes anti-scraping et renvoyer les données demandées via un simple appel API.

Le scraper asynchrone soumet les tâches via le point de terminaison async.scraperapi.com. Il exploite alors machine learning et une analyse statistique pour déterminer la combinaison optimale d'adresses IP, d'en-têtes, de résolution de CAPTCHA et d'autres configurations pour faciliter le scraping, même des sites Web les plus difficiles.

Les utilisateurs peuvent récupérer des millions d'URL sans gérer les délais d'attente ni les tentatives eux-mêmes : le grattoir asynchrone gère tout automatiquement. Les résultats sont renvoyés via un statut URL ou webhook dès que le scraping est terminé.

Les principaux avantages incluent Rendu JavaScript, ciblage géographique, rotation automatique des adresses IP, analyse de données structurées et résolution de CAPTCHA.

Le scraper asynchrone apporte toute la puissance de l'API traditionnelle de ScraperAPI avec la possibilité supplémentaire de gratter un nombre illimité de pages simultanément.

Le scraper asynchrone est idéal pour les projets de scraping à grande échelle qui nécessitent des données provenant de millions d'URL. Ses mécanismes automatisés et sa fiabilité le rendent parfait pour ceux qui ont besoin de supprimer des sites Web difficiles à grande échelle.

2. Rendu JavaScript

De nombreux sites Web s'appuient aujourd'hui fortement sur JavaScript pour afficher contenu. Les scrapers normaux ne peuvent pas extraire les données du contenu généré par JavaScript.

Impressionnant, les navigateurs sans tête de ScraperAPI affichent JavaScript à la volée avant le scraping. Cela permet de collecter des données de manière transparente, même à partir des sites JavaScript les plus complexes.

3. Résolution de CAPTCHA

Les CAPTCHA peuvent empêcher les scrapers d'accéder aux données. ScraperAPI a intégré OCR capacités pour résoudre automatiquement les CAPTCHA en temps réel. Cela contourne les CAPTCHA sans effort et sans aucun travail manuel.

4. Données structurées

ScraperAPI peut extraire des données structurées telles que des informations sur le produit, des données d'examen, des résultats de recherche, etc., et les afficher dans JSON le format.

Ces données structurées sont facilement utilisables pour les applications d'analyse et d'apprentissage automatique sans avoir besoin de nettoyage des données.

Par exemple, j'ai utilisé ScraperAPI pour extraire 5000 XNUMX Amazon listes de produits avec des informations structurées complètes telles que le titre, la note, le prix, etc. dans un seul appel API.

5. Grattage de Google et Amazon

ScraperAPI fournit des solutions spécialisées pour récupérer les données de Google et d'Amazon. Il permet aux utilisateurs d'extraire des données structurées de Google Shopping, de la recherche Google, de l'API Amazon Product Advertising, etc.

Cela m'a été d'une valeur inestimable pour obtenir des listes de produits, des résultats de recherche, des avis, des données sur les prix, etc. d'Amazon et de Google.

Pour Google, il peut collecter des données provenant de nombreuses requêtes de recherche et les convertir en données JSON structurées, qui peuvent être utilisées à diverses fins telles que des études de marché, Outils de référencementet la surveillance des concurrents.

Pour Amazon, ScraperAPI facilite le scraping de données à grande échelle, en contournant la technologie anti-scraping d'Amazon. Il fournit un guide pour récupérer les données Amazon à l'aide de Python Scrapy et ScraperAPI, et propose une fonction d'analyse automatique qui permet la collecte de données JSON d'Amazon à l'aide d'un point de terminaison API standard, renvoyant toutes les informations pertinentes dans un format structuré.

6. Pipeline de données

La fonctionnalité Data Pipeline de ScraperAPI vous permet d'automatiser des projets de récupération de données à grande échelle sans écrire une seule ligne de code.

Ce Low-code Cette solution réduit le besoin de codage complexe et de maintenance de votre propre grattoir, réduisant ainsi les ressources et les coûts d'ingénierie.

Avec Data Pipeline, vous pouvez planifier la collecte automatique de données sur jusqu'à 10,000 XNUMX URL, ce qui le rend idéal pour gérer de grands projets d'extraction de données.

Il vous offre un contrôle complet sur comment et où obtenir vos données, vous permettant d'envoyer des données directement vers n'importe quel dossier de votre application, espace de stockage de documents ou email.

En plus de cela, la fonctionnalité Data Pipeline propose également des intégrations de webhooks, éliminant ainsi le besoin de téléchargements manuels ou de copier-coller.

Coupon exclusif ScraperAPI 2024

10 % de réduction sur le coupon ScraperAPI

exclusif

Utilisez notre code promo exclusif "affnico10» et bénéficiez d'une réduction forfaitaire de 10 % sur tout plan d'abonnement ScraperAPI.

ÉCONOMIE 10%

Il convient de noter que vous pouvez économiser 20 % si vous implémentez notre code promo "affnico10» avec facturation annuelle soit ; 10% avec notre code de réduction + 10% avec la facturation annuelle de ScraperAPI.

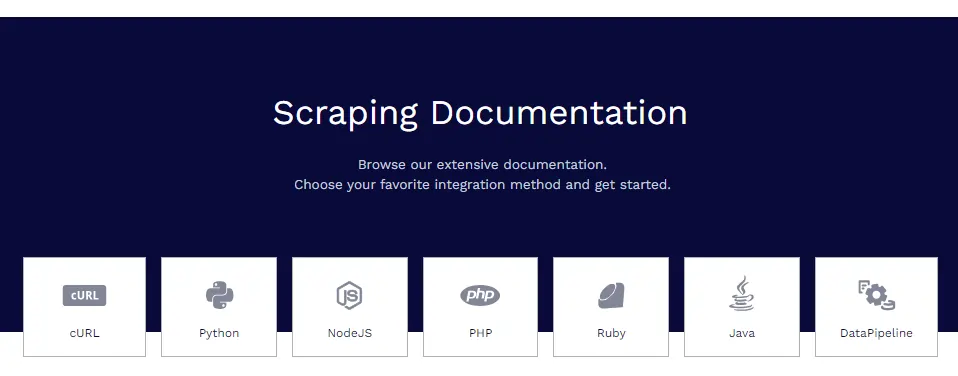

Documentation ScraperAPI

ScraperAPI dispose d'une documentation complète et bien organisée qui couvre toutes ses fonctionnalités en profondeur avec des exemples de code en Python, Node.js, Ruby, PHP, etc.

Certaines des ressources de documentation utiles sont :

- Mise en route – Installation, authentification et premier appel API.

- Extraction de données structurées – Récupération de données structurées du commerce électronique, des petites annonces, des annuaires, etc.

- Services Google – Guides pour supprimer Google Shopping, Google Maps, Google Flights et plus encore.

- Pipelines de données – Mise en place de pipelines de scraping automatisés.

- Format de réponse – Détails sur la structure de sortie JSON.

La documentation contient tout ce dont vous avez besoin pour maîtriser la récupération de données avec ScraperAPI.

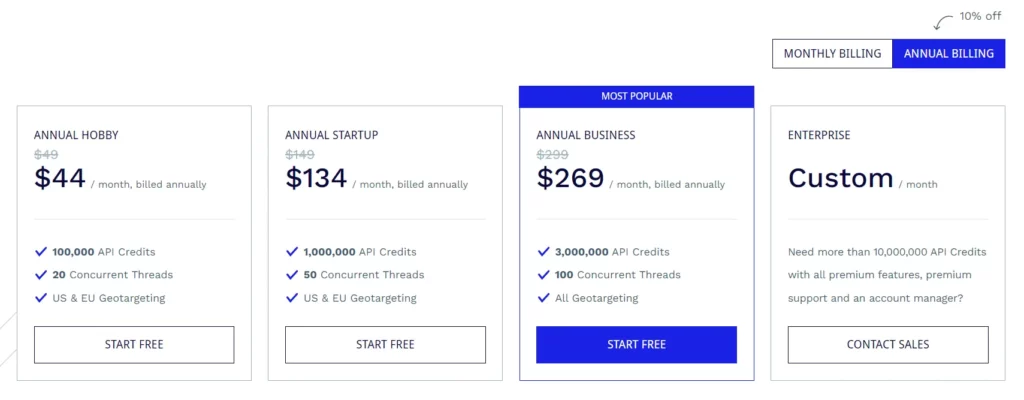

Plans d'abonnement ScraperAPI

Plan passe-temps (49 $/mois)

- 100,000 XNUMX crédits API

- 20 threads simultanés

- Ciblage géographique aux États-Unis et dans l'UE

Plan de démarrage (149 $/mois)

- 1,000,000 XNUMX crédits API

- 50 threads simultanés

- Ciblage géographique aux États-Unis et dans l'UE

Plan d'affaires (299 $/mois)

- 3,000,000 XNUMX crédits API

- 100 threads simultanés

- Toutes les options de ciblage géographique

Plan d'entreprise (tarification personnalisée)

- Plan personnalisé pour plus de 10,000,000 XNUMX XNUMX de crédits API.

- Fonctionnalités premium, support premium et gestionnaire de compte dédié.

Tous les forfaits sont dotés de fonctionnalités telles que le rendu JavaScript, les proxys Premium, l'analyse automatique JSON, la rotation des proxys intelligents, la prise en charge des en-têtes personnalisés, la bande passante illimitée, les tentatives automatiques, les agents utilisateurs de bureau et mobiles, la garantie de disponibilité de 99.9 %, la prise en charge des sessions personnalisées, le CAPTCHA et l'anti-bot. Détection et support professionnel.

ScraperAPI propose également un essai gratuit qui comprend 5,000 7 crédits API pendant XNUMX jours.

Quelques ressources gratuites de ScraperAPI

En plus de l'API, ScraperAPI propose également de nombreuses ressources gratuites pour apprendre le web scraping :

Centre d'apprentissage du Web Scraping

Les Web Scraping Learning Hub contient des didacticiels et des guides gratuits pour maîtriser le web scraping avec Python et d'autres langages.

Ebooks

ScraperAPI a publié des ebooks gratuits utiles comme « Web Scraping : The Basics Explained » qui enseignent les principes fondamentaux du web scraping.

Webinaires

Ils organisent des webinaires gratuits sur des sujets tels que « Scraping JavaScript Websites », « Building Data Pipelines », etc., qui fournissent des conseils pratiques.

Projets de démonstration

Les projets de démonstration incluent des scripts de scraping Web entièrement codés pour des tâches de scraping réelles dont vous pouvez apprendre.

Blog

ScraperAPI blogue contient des didacticiels et des articles sur les meilleures pratiques de web scraping. Ces ressources gratuites sont inestimables pour maîtriser le web scraping sans frais. Ils complètent le API bien.

Foire aux Questions

ScraperAPI gère-t-il les proxys et les navigateurs ?

Oui, ScraperAPI gère automatiquement un réseau distribué de proxys et de navigateurs en arrière-plan. Vous n’avez pas du tout besoin de vous soucier des procurations.

Puis-je récupérer les données derrière les connexions ?

Oui, ScraperAPI prend en charge la récupération des données derrière les connexions en transmettant des cookies dans la requête API pour maintenir les sessions.

ScraperAPI s'intègre-t-il à Python ?

Oui, ScraperAPI fournit une bibliothèque Python qui rend l'intégration transparente. Des bibliothèques pour Node.js, Ruby, PHP, etc. sont également disponibles.

Puis-je supprimer des sites Web JavaScript ?

Décidément, les navigateurs sans tête de ScraperAPI affichent du JavaScript avant le scraping, donc les sites JS ne posent pas de problème.

Conclusion de l'examen de ScraperAPI

Après avoir largement utilisé ScraperAPI dans mes différents projets, je peux garantir en toute confiance sa qualité et sa fiabilité.

Pour mes besoins de web scraping, ScraperAPI coche toutes les bonnes cases. J'ai essayé des concurrents comme Apify, Octoparse, ParseHub, etc. mais je trouve que ScraperAPI est le meilleur en termes de fonctionnalités, de commodité et de prix.

Je recommande fortement ScraperAPI à toute personne, équipe ou entreprise ayant besoin d'extraire des données Web à grande échelle. Cela vous fera sûrement économiser des heures de travail complexe de codage et de configuration afin que vous puissiez vous concentrer sur l'extraction d'informations à partir des données.

Liens rapides:

- HilltopAds Review 2023 : tous les réseaux GEO à CPM élevé sont là

- Zeydoo Review 2023 : Maximisez vos revenus avec Zeydoo

- 8 meilleurs navigateurs antidétection pour les affiliés 2023 (gratuits et payants)

- Minea Review 2023 : un outil de recherche de produits avancé (coupons et codes promotionnels Minea)

Affiliation Divulgation: Ce message peut contenir des liens d'affiliation, ce qui signifie que nous pouvons recevoir une commission si vous achetez quelque chose que nous recommandons sans frais supplémentaires pour vous (aucun !)

![Writesonic Review 2024 : L'outil de rédaction ultime [Avantages et inconvénients] 11 Writesonic Review 2024 : l'outil de rédaction ultime [Avantages et inconvénients]](https://bloggingeclipse.com/wp-content/uploads/2022/03/Writesonic-Review-1024x512.webp)